先前傳聞是說 OpenAI 會推出多款模型,但本週一時,就只有 GPT-4.1 系列,而且還僅推出給 API,對於期待其他模型的人來說,一定都在敲碗到底什麼時候能見到。而 OpenAI 也沒讓大家等太久,稍早正式推出目前最強大的 o3、o4-mini 模型,也是首款能夠融入圖像思考的 OpenAI 模型。ChatGPT Plus、Pro 用戶即刻就能使用,免費版則可以用到 o4-mini。

融入圖像思考的 OpenAI o3、o4-mini 模型正式亮相

OpenAI 正式推出 o3、o4-mini 系列模型,除了是目前最強大之外,還有幾點跟過往的模型不太一樣:

- 融入圖像思考

- 可使用所有 ChatGPT 工具,包括搜尋網頁、使用 Python 分析上傳的檔案和其他資料、對視覺輸入進行深入推理,甚至是生成圖片都可以

當然,效能部分也比先前 OpenAI 模型還要強。首先來看 o3 模型。

相較於前一代 o1 模型,o3 在程式設計、數學、科學、視覺感知等多個方面都變得更強,OpenAI 表示,o3 在 Codeforces、SWE-bench 以及 MMMU 等基準測試中,創下新的成績。

o3 非常適合用在多面向分析,以及一些複雜的查詢,視覺任務方面表現特別出色,重大錯誤率也比 o1 低約 20%。

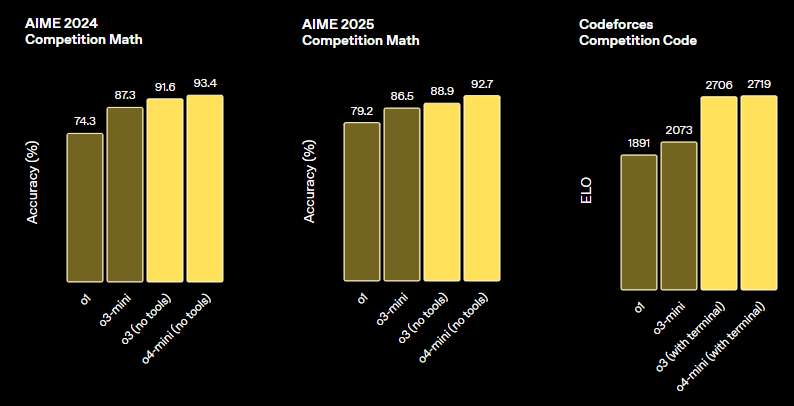

而 o4‑mini 則是一款經過優化的小型推理模型,兼顧速度與成本效益,用於取代之前的 o3-mini。在數學、程式設計和視覺任務上,表現都相當不錯,而是 AIME 2024 與 2025 基準測試中得分最高的模型。

o4‑mini 有著更高的使用量限制,因此對於需要多次推理查詢的任務,是非常不錯選項。

下方是各項測試數據。

在 AIME 2024、2025、以及 Codeforces 測試中,o4-mini 明顯領先 o3-mini:

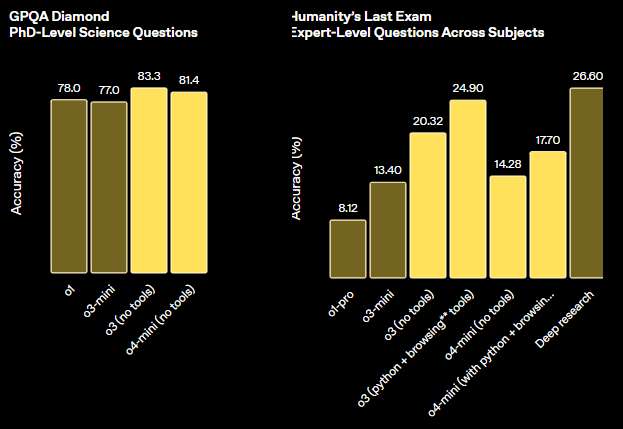

物理學博士程度的知識、多個領域的專家級問題的準確率,o3 和 o4-mini 也拿到相當不錯的成績,同樣優於前一代不少:

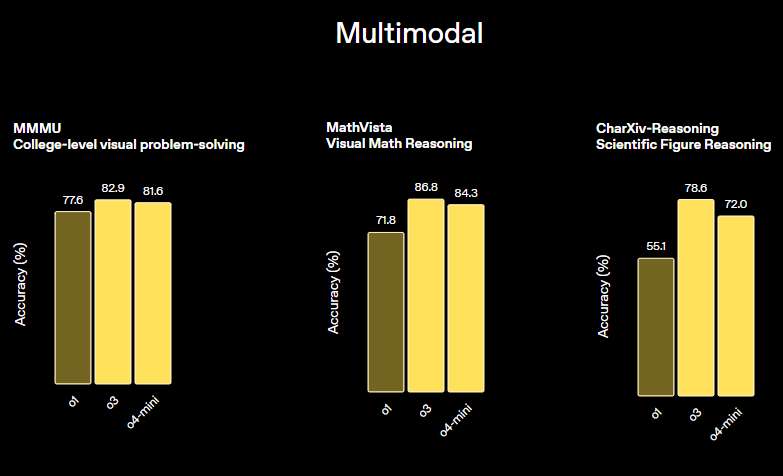

多模態測試,o4-mini 就已經比 o1 高出不少,o3 更不用說:

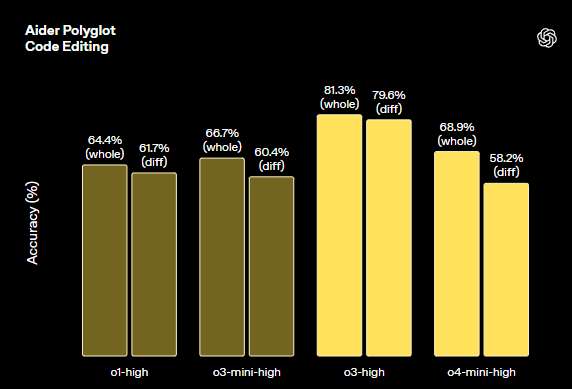

程式編輯的準確率,比較的都是各模型 high 版本:

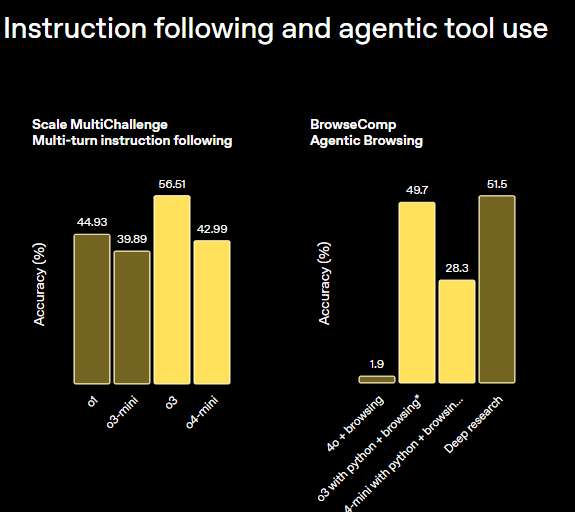

指令理解與工具操作成績,o3 可說表現相當棒,光是 python + 上網瀏覽操作,就已經能做到跟深入搜尋 Deep research 差不多的效果:

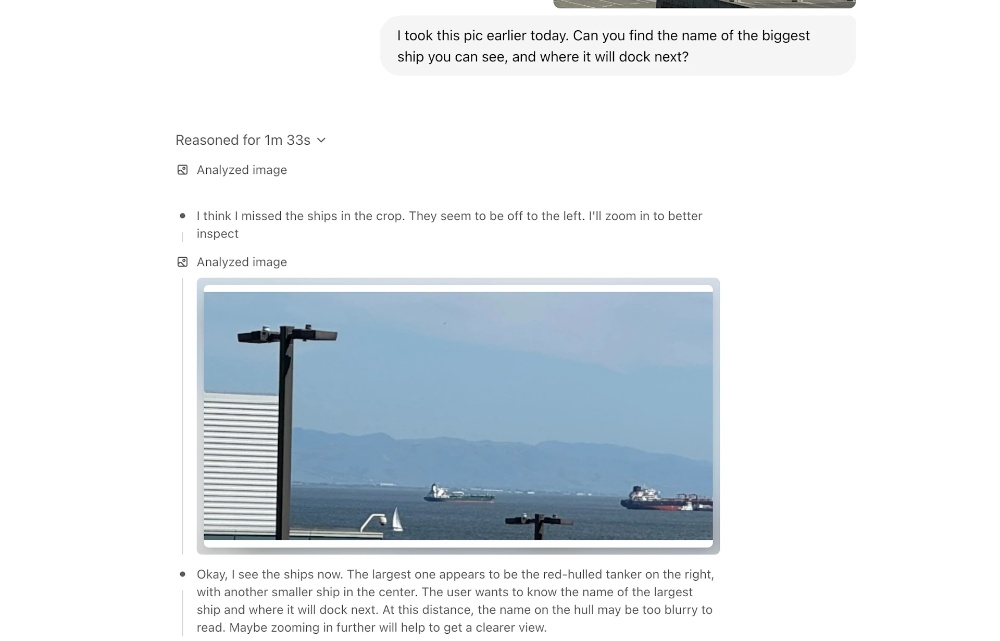

關於融入的圖像思考,簡單來說就是 o3 和 o4-mini 不是只有「看」影像,也會將影像納入一同思考,這開啟一種全新的問題解決方式,融合視覺與文字推理:

更值得注意的一件事是,OpenAI 還提到這些模型可以即時操作影像,像是旋轉、縮放或變形,由此可見未來 ChatGPT 搞不好慢慢可以取代許多影像編輯軟體能做到的事情。

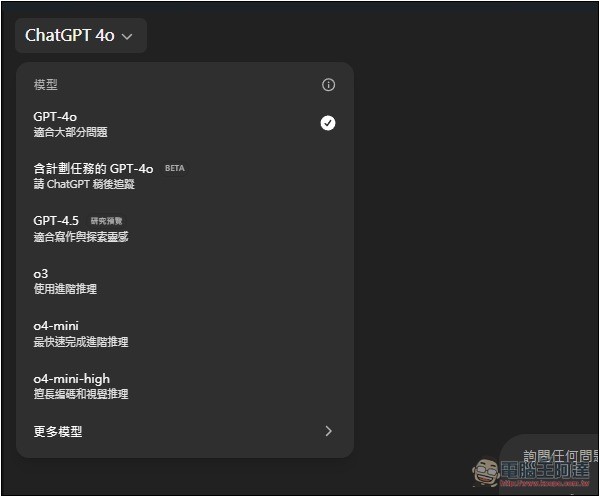

從即刻起,ChatGPT Plus、Pro 與 Team 用戶的模型選單,將會看到 o3、o4‑mini 及 o4‑mini‑high,取代原來的 o1、o3‑mini 與 o3‑mini‑high:

ChatGPT Enterprise 及 Edu 用戶則預計一週後就能使用。

免費用戶詢問之前先啟用「推理」模式,就能體驗到 o4‑mini。

OpenAI 還預告,幾週內會推出具備完整工具支援的 o3‑pro。目前 Pro 用戶仍可繼續使用 o1‑pro。

o3 和 o4-mini 有使用限制嗎?

OpenAI 表示,各方案的 o3 和 o4-mini 使用限制就跟前一個版本一樣,代表說:

- ChatGPT Plus、Team 和 Enterprise 用戶每週可用 o3 模型 50 則訊息。每天可用 o4-mini 共 150 則訊息,每天可用 o4-mini-high 共 50 則訊息。

- ChatGPT Pro 的 o3、o4-mini 和 4o 模型幾乎無限制。

- ChatGPT 免費版無法使用 o3,o4-mini 有使用次數限制,實際多少官方沒有公布