近日 Google DeepMind 推出基於 Gemini 2.0 大型語言模型的先進視覺-語言-動作(VLA)模型「Gemini Robotics」,稱有了 Gemini Robotics 之後機器人就能提升在現實世界中執行任務的能力。Gemini Robotics 具備通用性、互動性和靈巧性,且不侷限於單一機器人型態,不管你是雙足人形機器人還是雙臂機器人都可以使用 Gemini Robotics 模型。一起來看看 Google DeepMind 新推出的 Gemini Robotics VLA 模型能讓機器人產生什麼變化吧!

Google DeepMind 推出自家 VLA 模型「Gemini Robotics」,讓機器人能夠做到摺紙、投籃等等高精度動作

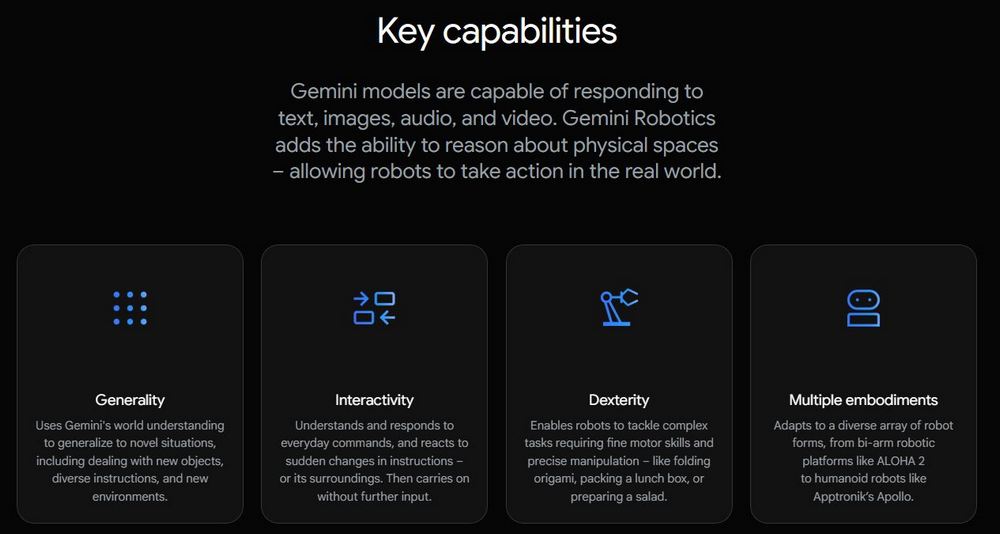

Google DeepMind 發表自家基於 Gemini 2.0 大型語言模型的先進視覺語言動作模型「Gemini Robotics」,使用 Gemini Robotics 的機器人能夠回應文字、圖片、聲音和影片,增加了對物理空間進行推理的能力。

Gemini Robotics 是 Google DeepMind 最新推出的人工智慧模型,旨在提升機器人在現實世界中執行複雜任務的能力。該模型結合了語言、視覺和動作,讓機器人能夠理解並適應各種環境,執行如摺紙、整理桌面、包裝耳機線和投籃等任務。

Gemini Robotics 模型可以利用 Gemini 對世界的理解能力,快速適應新情境,包含處理之前沒有訓練過的新物體。同時也能理解並回應日常指令,對突然變化的指令或環境作出反應。像是玩圈圈叉叉、根據需求拼字、將食物放進餐袋中。

最厲害的是 Gemini Robotics 模型適應各種機器人型態,從雙臂機器人平台到人形機器人都可以使用 Gemini Robotics 模型。根據 Google DeepMind 提供的資訊,現在與 Apptronik、Agile Robots、Agility Robotics、Boston Dynamics 和 Enchanted Tools 等機器人開發公司都有合作。

除了上面提到的 Gemini Robotics 模型以外,Google DeepMind 還推出專注提升機器人推理能力的 Gemini Robotics-ER 模型。Gemini Robotics-ER 模型支持開發者利用其提供的推理能力運行自定義程序。