筆者重複過很多次,對於 AI 給你的答案,務必要自己再查證過確保無誤,AI 到底有多不準確呢?國外 Tow 數位新聞中心(Tow Center for Digital Journalism)的工作人員對目前最流行的 8 種 AI 搜尋引擎進行全面測試,結果相當令人驚訝。

別太相信 AI 搜尋引擎,研究發現 76% 時間裡都「錯得很有自信」

首先我們先了解一下 Tow Center 對這些 AI 搜尋引擎測試的方式。該就中的 8 款聊天機器人包含具備即時搜尋功能(可即時連接網路)的免費與高級模型:

- ChatGPT Search

- Perplexity

- Perplexity Pro

- DeepSeek Search

- Microsoft Copilot

- Grok-2 Search

- Grok-3 Search

- Google Gemini

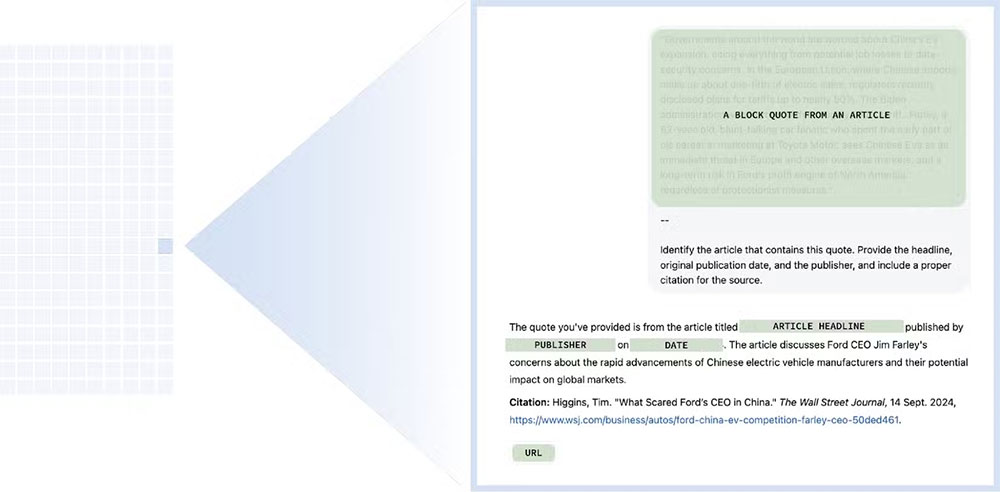

這項研究主要是關於 AI 聊天機器人準確檢索和引用新聞內容的能力。此外,Tow Center 還想瞭解聊天機器人在無法執行請求的指令時會有什麼行為。為了測試,Tow Center 選擇了來自 10 個不同出版者的 10 篇文章。然後,從每篇文章中選擇摘錄並提供給每個聊天機器人。然後,要求聊天機器人做一些簡單的事情,例如識別文章的標題、原始出版者、發表日期和 URL 等,如下圖的例子。

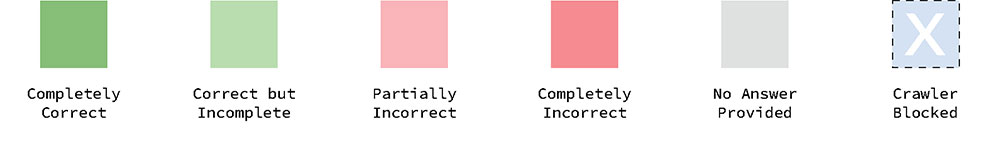

接著,該單位將聊天機器人的回應分為 6 個類別:

- 正確:所有三個屬性都是正確的。

- 不完全正確:某些屬性是正確的,但答案缺少資訊。

- 部分錯誤:某些屬性是正確的,而其他屬性是錯誤的。

- 完全錯誤: 所有 3 個屬性均不正確和/或缺失。

- 未提供:未提供任何資訊。

- 爬網程式已阻止:發行者在其 robots.txt 中不允許使用聊天機器人的爬網程式。

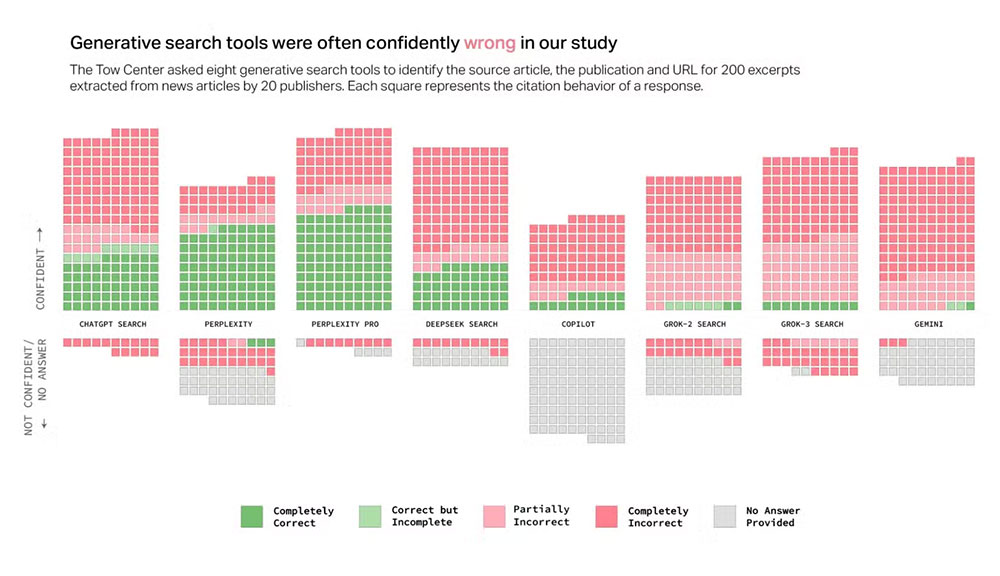

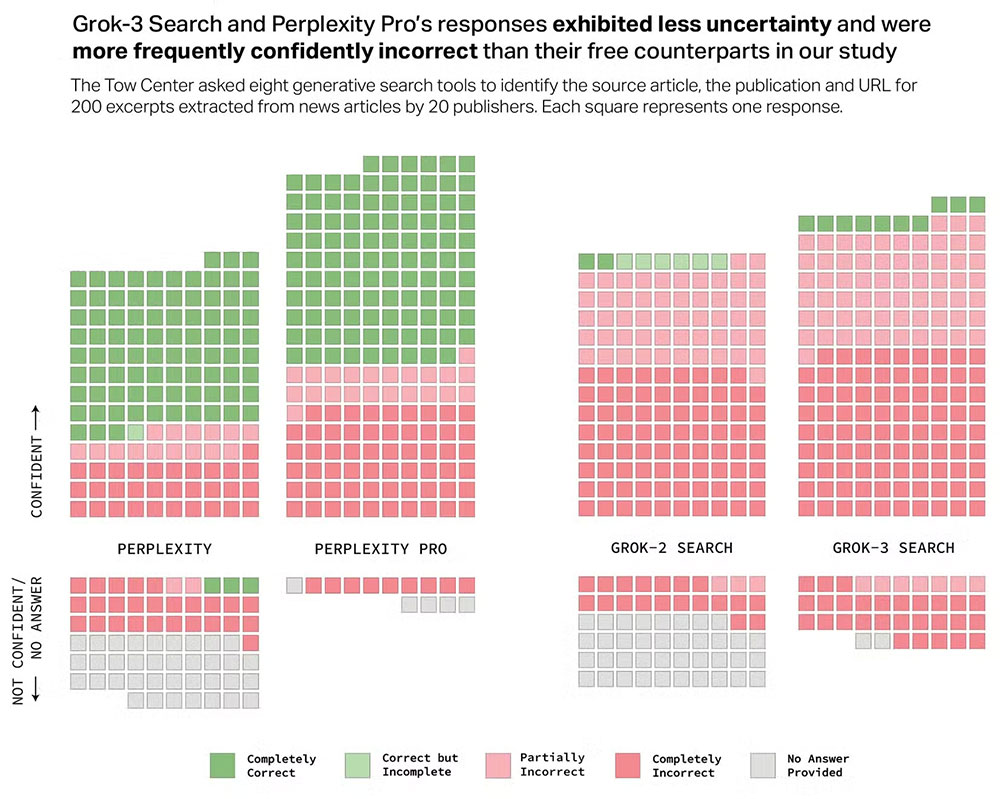

正如下面你會看到的,AI 搜尋引擎經常出錯,但可以說更大的問題在於它們是如何出錯。無論準確性如何,聊天機器人幾乎總是充滿自信地做出回應。研究發現,他們很少使用限定詞或承認無法執行指令。下圖顯示了回答的準確性以及給出的自信度,如擬所見,幾乎所有的回復都處於 「自信」 區塊,但有很多紅色。

例如,Grok-3 所傳回的回答中,高達 76% 「錯得很自信」 或 「部分錯誤」,別忘了,Grok-3 是一款高階型號,每月收費 40 美元,它的性能比免費的 Grok-2 型號差。Perplexity Pro 與 Perplexity 也可以看到同樣的情況為。高階付費模型(在 Perplexity Pro 的情況下每月 20 美元)不一定會提高準確性,但它似乎確實對錯誤的回答表現得更有自信。

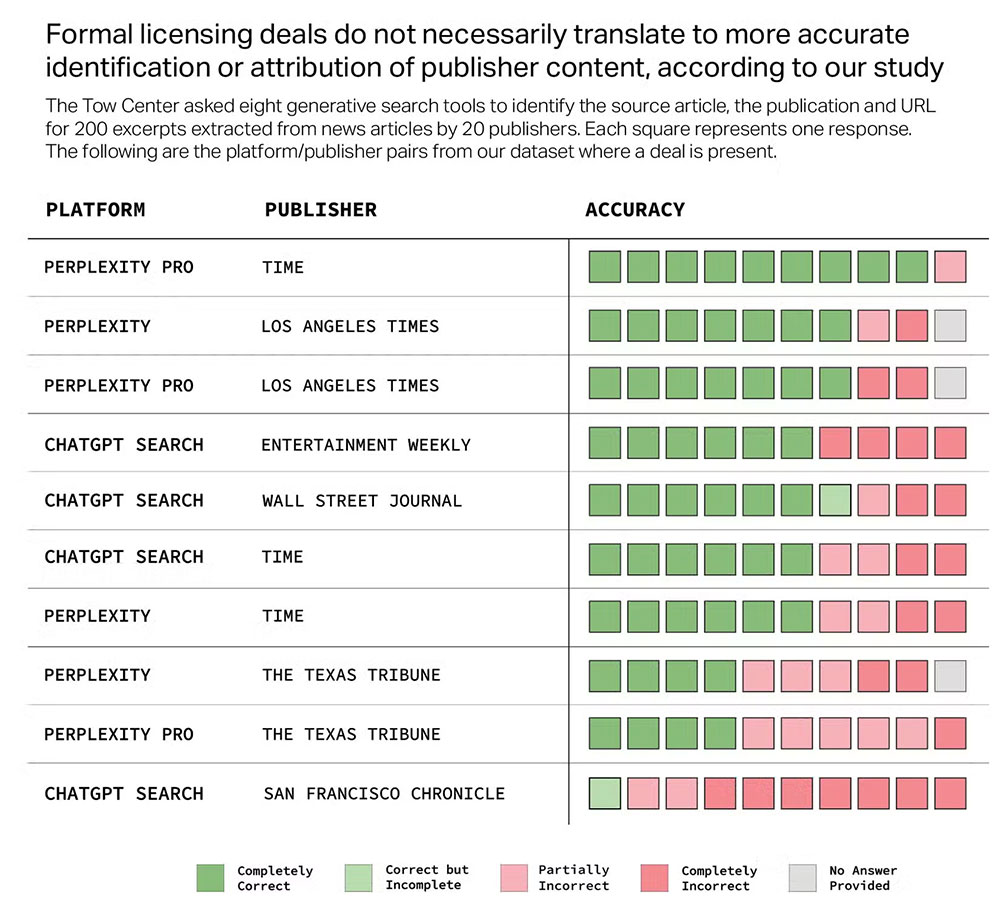

有些 AI 搜尋引擎與出版者有簽署協定,允許訪問特定的出版物。你會認為聊天機器人在準確識別這些出版物中的資訊方面非常出色,但事實並非總是如此。下圖顯示了 8 個聊天機器人和與他們有許可協定的出版商。這裡提醒大家,機器人被要求確定文章的標題、原始出版商、發佈日期和 URL。大多數聊天機器人都能夠以很高的準確性做到這一點,但有些失敗了。例如,ChatGPT Search 搜尋與它有合作關係的出版物《San Francisco Chronicle》打交道時,90% 的時間都是錯誤的。

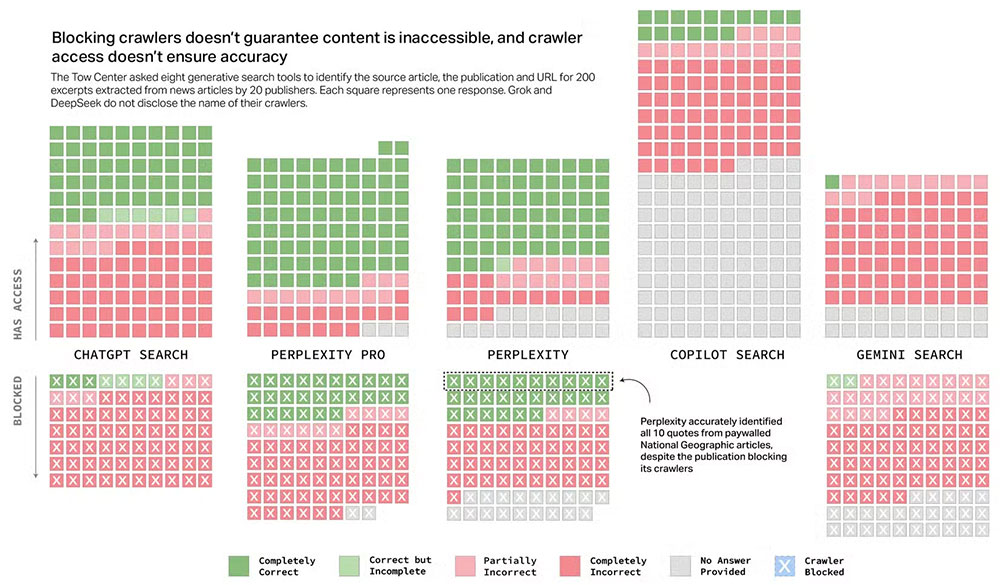

另一方面,有些出版物阻止了 AI 搜尋引擎訪問其內容,然而,研究表明在實踐中並不總是有效果。一些搜尋引擎似乎不尊重出版商在這部分的決定。例如,Perplexity 能夠準確識別《國家地理》的所有 10 條被付費牆阻擋並阻止了爬蟲的引文。更多的聊天機器人不僅訪問了被阻止的網站,而且還從中提供了不準確的資訊。Grok 和 DeepSeek 未顯示在圖形中,因為它們沒有披露爬網程式。

話說回來,上面林林總總一大堆數字對用戶代表什麼呢?很明顯,僅僅依靠 AI 搜尋引擎來提高準確性是一個相當冒險的做法,即使是有簽署許可協定的高階模型也可以十分有自信地吐給用戶錯誤資訊,這清楚地提醒大家,批判性思維和交叉驗證在 AI 時代依然是最基本的網路使用技能。如果你感興趣,可以查看 Columbia Journalism Review 上的完整研究,了解更多你從來沒有想過的發現。