對於需要輕薄筆電的用戶,一定會考慮要不要入手 Apple 最新推出的 M4 MacBook Air,而在這 AI 時代裡,除了一般的效能和續航力之外,很多人還會考量是否能在本地運行 AI 模型,而 MacBook Air 沒有內建風扇,一定會擔心是否代表 AI 效能沒有很好?

稍早知名評測頻道極客灣Geekerwan 分享的 M4 MacBook Air 評測影片中,就有提供 AI 模型的測試數據,如果你是買 32GB 記憶體版本,那 32B 的 AI 語言模型也跑得動。

無風扇 M4 MacBook Air 運行 AI 大語言模型比 Intel Ultra 7 258V 筆電還強

在先前的 M4 MacBook Air 發表會文章中,我們已經有詳細介紹其特色,極客灣Geekerwan 影片中也有分享很多效能測試,有興趣了解的人,可以觀看文末影片,這邊直接來看 AI 大語言模型的測試數據。。

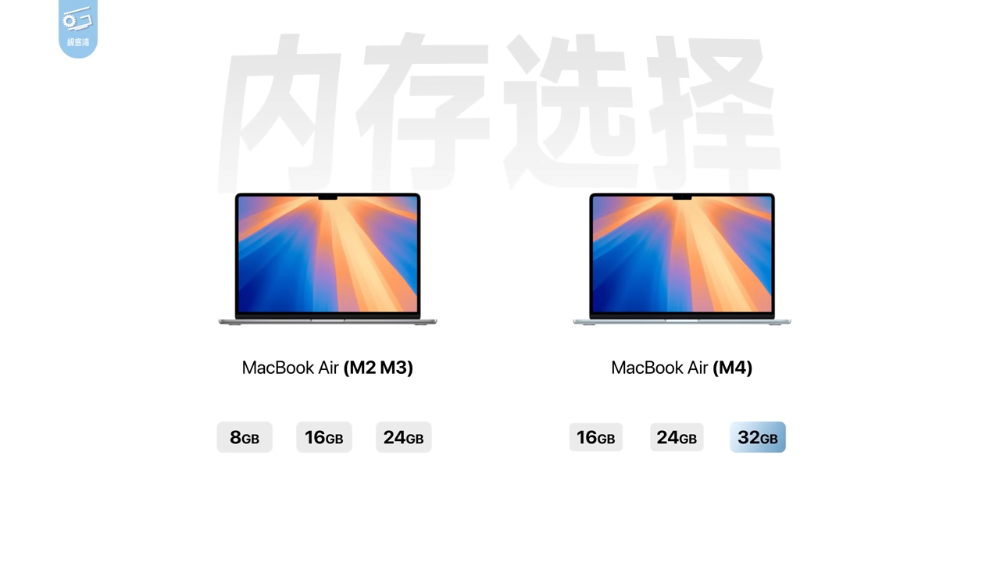

M4 MacBook Air 有提供 16GB、24GB 以及 32GB 三種記憶體容量選擇,既然是統一記憶體,對於 AI 應用來說,當然是越高越好,非常推薦直上 32GB,而極客灣Geekerwan 測試使用的 M4 MacBook Air 也是 32GB 版本。

M2 和 M3 時代的 MacBook Air 最大只到 24GB,這次 M4 多了 32GB 選項,真的是一大好消息:

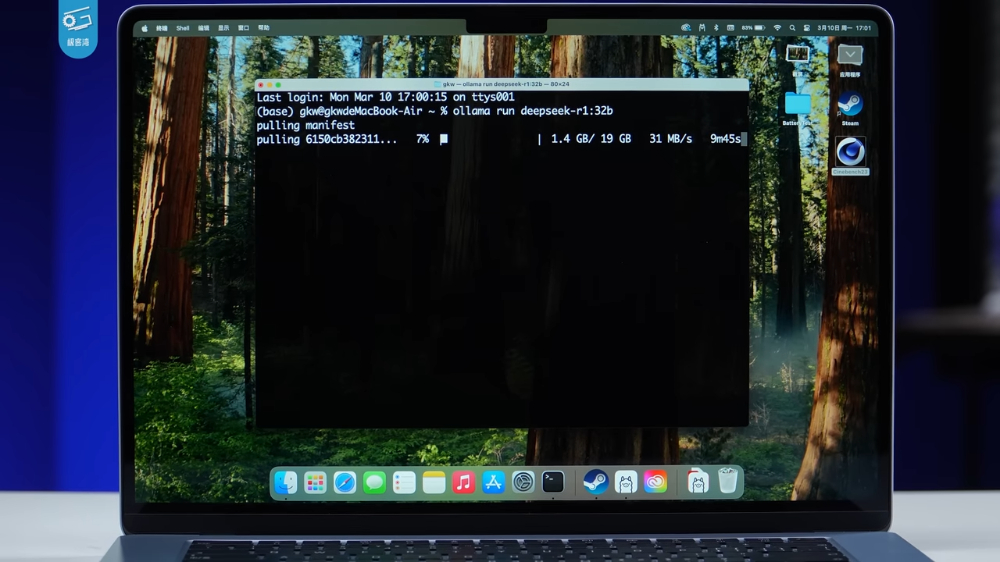

測試的軟體則是 Ollama,相較於 Intel,Mac 在本地部署 Ollama 的方式很簡單,只需要到官網下載安裝檔,然後照步驟安裝即可部署完成:

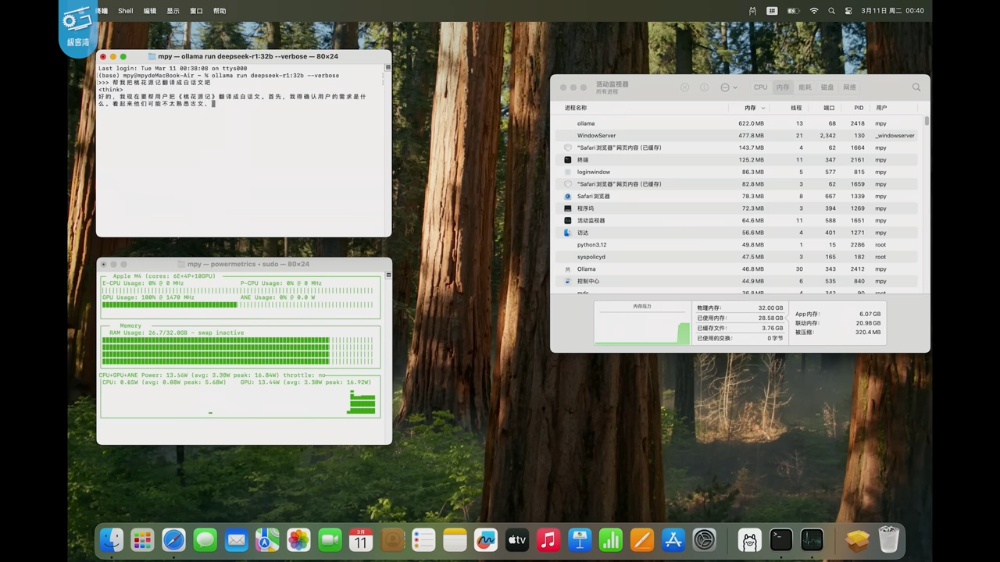

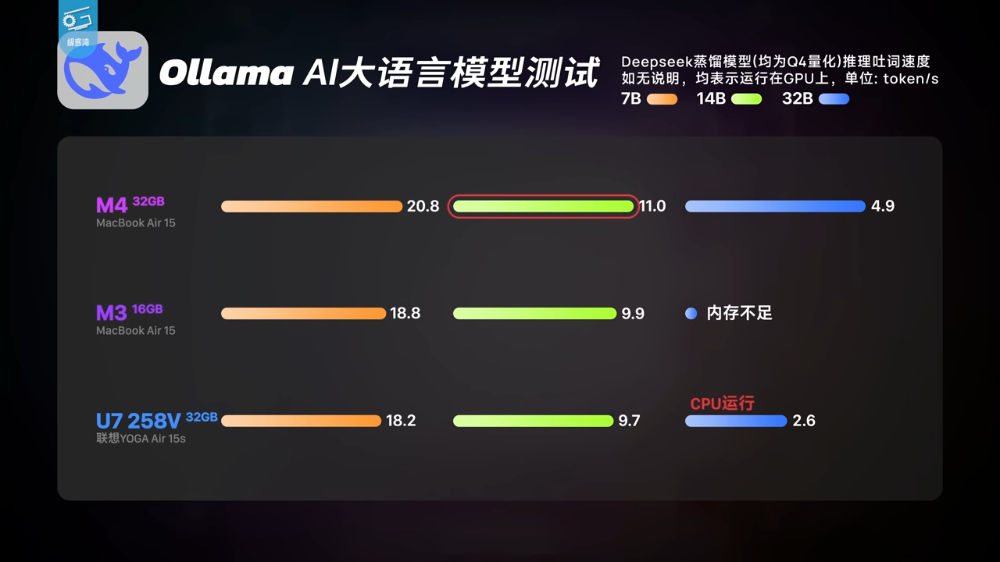

極客灣Geekerwan 測試無論是 DeepSeek-R1 的 32B 參數模型,還是 Qwen 32B 模型,M4 MacBook Air 都跑得動。雖然可以,但我看影片的輸出速度還是稍微慢一點,我是覺得 14B 更推薦:

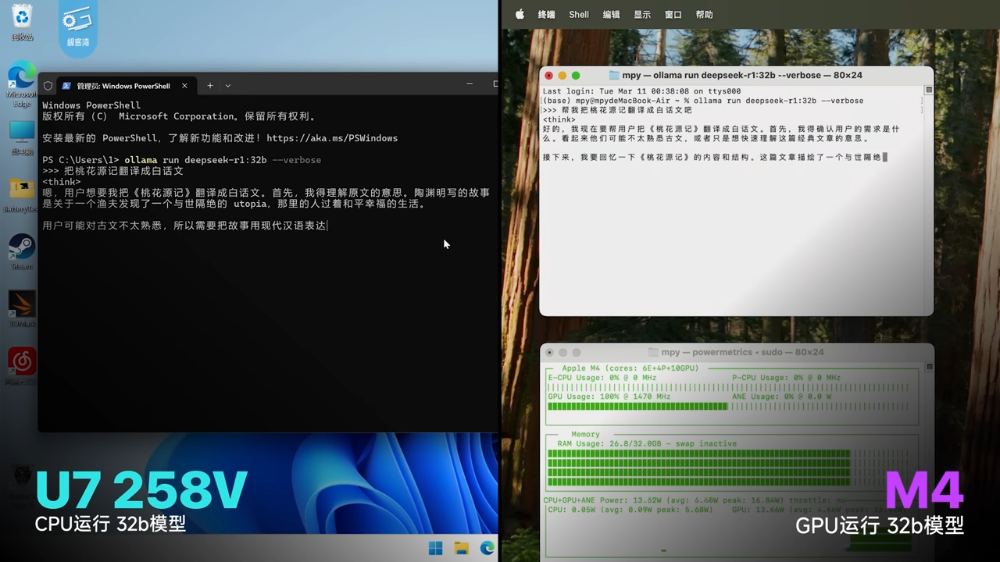

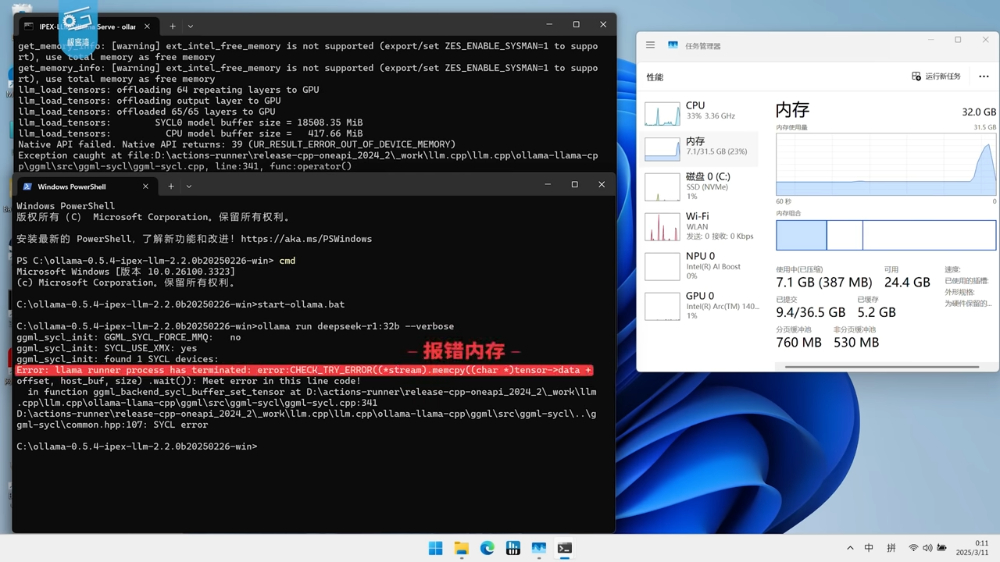

之前他們也有測試 Intel Ultra 7 258V + 32GB 記憶體的筆電,如果是在 GPU 上運行,會跑不到,出現記憶體出錯,但切換成 CPU 後就沒問題,不過速度超級慢。由此可見是 GPU 顯示記憶體無法滿足 32B 模型需求:

下圖是實際數據,M4 MacBook Air 運行 DeepSeek 7B 模型時,可提供 20.8 tokens/s、14B 為 11 tokens/s、32B 則是 4.9 tokens/s,M3 MacBook Air 他們使用的是 16GB 版,14B 也沒問題,也有 9.9 tokens/s 的速度,但 32B 就記憶體不足了:

而跟競爭對手 Intel Ultra 7 258V 相比,M4 MacBook Air 明顯快不少,尤其是 32B 模型。

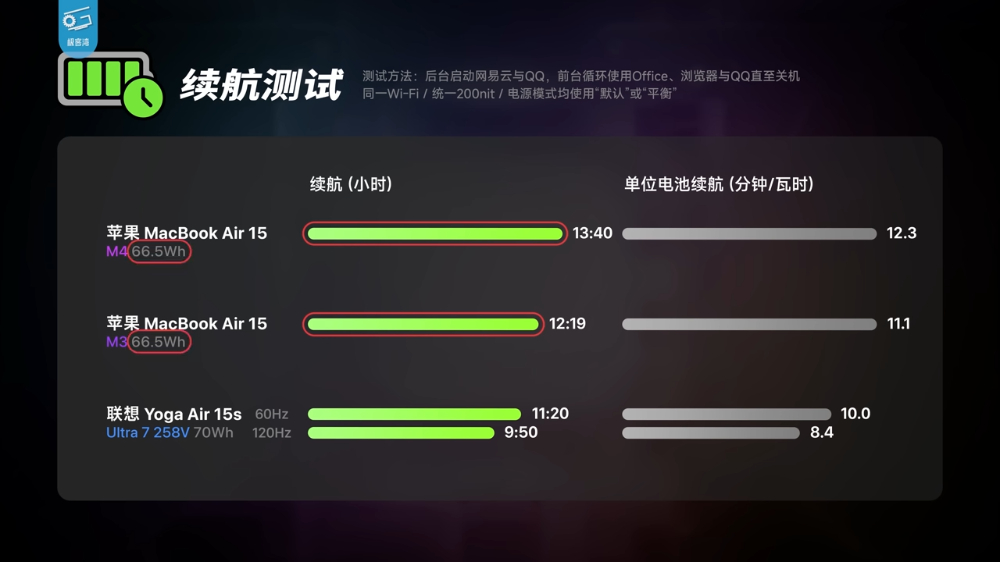

續航測試也分享給大家,M4 比上一代 M3 還多了 1 小時21 分鐘,達到將近 14 小時:

極客灣Geekerwan 完整影片: