隨著大語言模型越來越強,很多人都會想在本地架設 AI 模型,不過如果要運行千億以上超大參數的 AI 模型,光是 1 張 AI GPU 絕對不夠,至少要 6 張以上,總價隨隨便便就破百萬。近日中國 B 站就有人分享滿血版 M3 Ultra 本地運行 671B 參數的 DeepSeeK R1 模型測試,結果速度比 8 張 A100 還快,但總價卻便宜好幾倍。

由此可見,相較於 GPU,M3 Ultra 是目前在本地架設大語言模型最經濟實惠的方法之一,事實上很多 M 系列晶片都比 GPU 還要划算。

M3 Ultra 可說是本地架大語言模型,CP 值最高的方法之一

近日中國 B 站頻道 “雖然但是張黑黑”,上傳一部「速度媲美官網?滿血 M3 Ultra 推理 6000 億參數 DeepSeek R1」的影片,內容分享他用 M3 Ultra 運行 DeepSeek R1 的實測數據。

首先你要知道的是,一般來說,如果要在本地運行多達 6000 億參數的 DeepSeek R1 大模型,你可能需要使用一台售價上百萬,搭載 6~8 張 A100 專業級伺服器才能做到,這根本不是普通人可以負擔得起:

但有了滿血版 M3 Ultra 後,只需要這台 Mac,就能跑出跟 8 張 A100 差不多等級的速度。

目前 DeepSeek 效能最強的有二個模型,一個 R1,另一個則是 V3,簡單來說,打開 DeepSeek 官網聊天時所使用的模型是 V3,而開啟下方深度思考的話,就會變成 R1 模型:

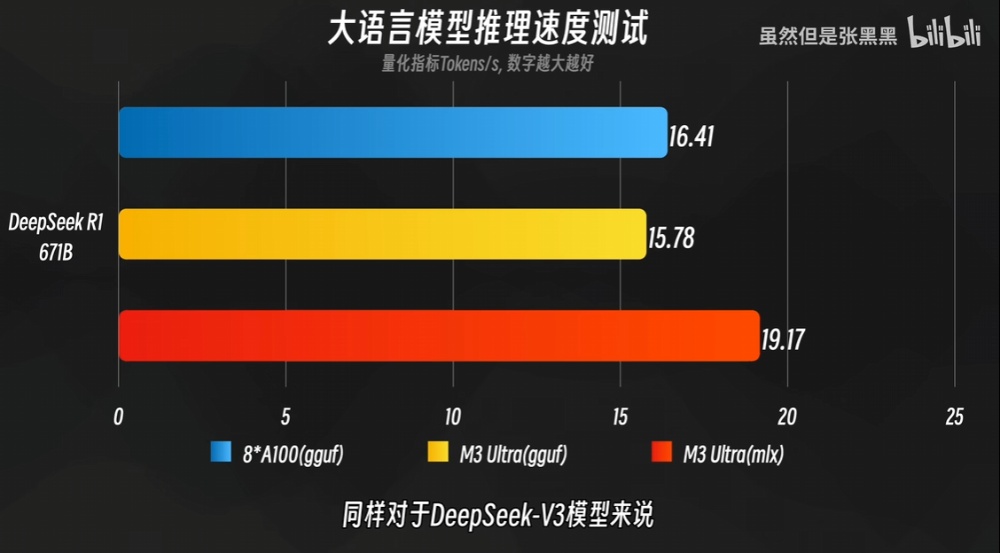

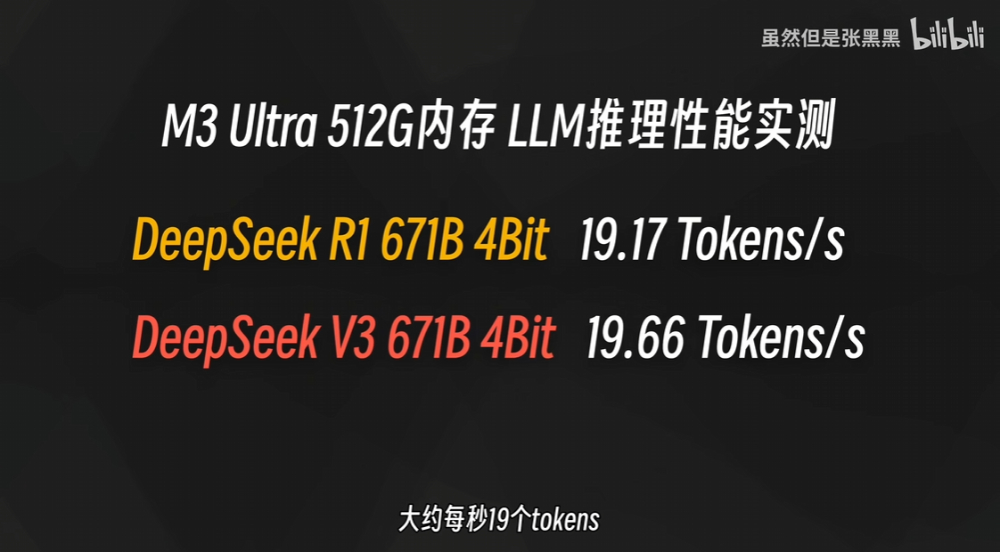

8 張 A100 的情況下,運行 DeepSeek R1 671B 可提供 16.41 Tokens/s。而 M3 Ultra 同樣 GGUF 格式中,速度是 15.78 Tokens/s,改成能發揮統一記憶體優勢的 MLX 格式後,速度就超越 8 張 A100 了,速度來到 19.17 Tokens/s:

DeepSeek V3 671B 也是一樣,速度達到 19.66Tokens/s:

當然,這並不代表滿血版 M3 Ultra 完全擊敗 A100,影片中也有解釋到,單用戶進行單一模型推理,主要看重的是記憶體頻寬和大小,無法完全展示 8 張 A100 顯卡的實力。

如果變成多用戶推理,以及大模型訓練的話,那 M3 Ultra 就完全比不上。

他用的滿血版 M3 Ultra 是配備 512GB 統一記憶體,另外還有其他客製化規格,總價 74,249 人民幣,約 33.6 萬台幣:

對多數人來說,這台確實規格很豪華,如果你不需要運行這麼大參數的模型,統一記憶體就不用加到這麼大,價格部分也會省很多。

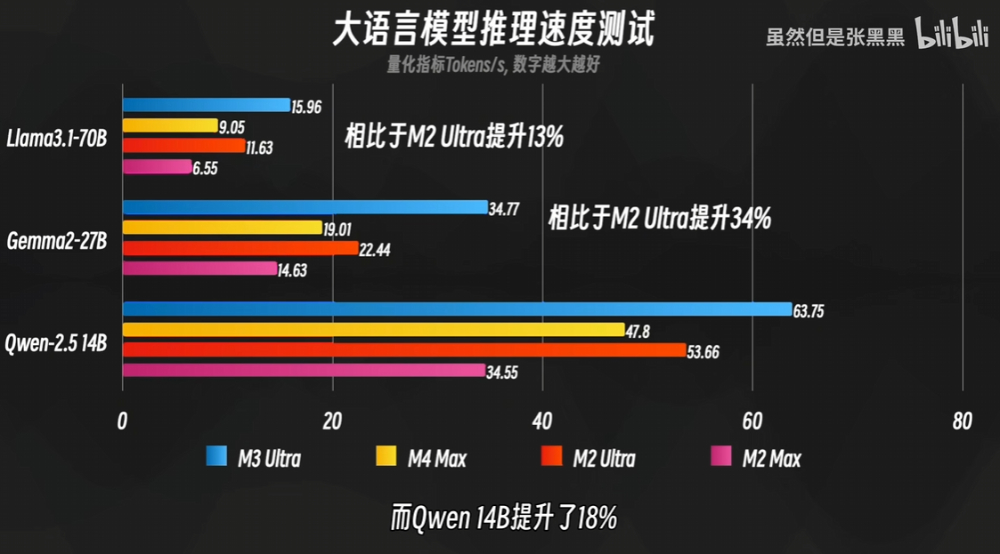

至於處理器是否一定要選 M3 Ultra?如果可以當然推薦。

下圖是和其他 M 系列對比的大語言模型推理速度測試,可以看到,無論是 Llama 3.1 70B、Gemma2 27B、或 Qwen 2.5 14B,M3 Ultra 的速度都明顯優於其他 M 系列,跟 M2 Ultra 相比,速度提升了 13%、34%、以及 18%:

「速度媲美官網?滿血 M3 Ultra 推理 6000 億參數 DeepSeek R1」完整影片: