近日 stability.ai 推出了新一代 AI 圖片生成模型 Stable Diffusion 3.5,同樣是開源讓大家免費使用,跟 SD3.0 相比,效能不僅變得更強,生成品質也更好,而且不需要大量 Prompt 就能生成出不錯的 AI 圖,並支援多種風格。如果你想試試看,這篇就來教你怎麼免費線上用,以及在本地安裝使用。

Stable Diffusion 3.5 模型版本差異

Stable Diffusion 3.5 共有三種版本, Large、 Large Turbo 和 Medium,Medium 預計 10 月 29 日才會釋出,其他則現在就能使用到:

- Stable Diffusion 3.5 Large:擁有 80 億個參數,生成品質最好,且對提示指令反應極為精確,是 Stable Diffusion 系列中效能最強大的基礎模型。適合專業用途,支援 1 百萬像素的解析度圖片生成。建議 16GB 以上 VRAM 顯卡使用。

- Stable Diffusion 3.5 Large Turbo:Stable Diffusion 3.5 Large 精簡版,僅需 4 步驟就能生成高品質圖像,速度快很多。建議 8GB 以上 VRAM 顯卡使用。

- Stable Diffusion 3.5 Medium(10 月 29 日推出):擁有 25 億個參數,採用改良的 MMDiT-X 架構與訓練技術,專為多數消費者的硬體而設計,並在 0.25 到 2 百萬像素解析度範圍內生成圖片。如果你的硬體比較差,那就建議等這一個。

如何線上使用 Stable Diffusion 3.5 圖片生成

如果你想先玩玩看,再決定要不要本地安裝,或的電腦顯卡沒有到 8GB,Stability.ai 已經有在 Hugging Face 上架設 Stable Diffusion 3.5 Large、Stable Diffusion 3.5 Large Turbo 的線上版本。

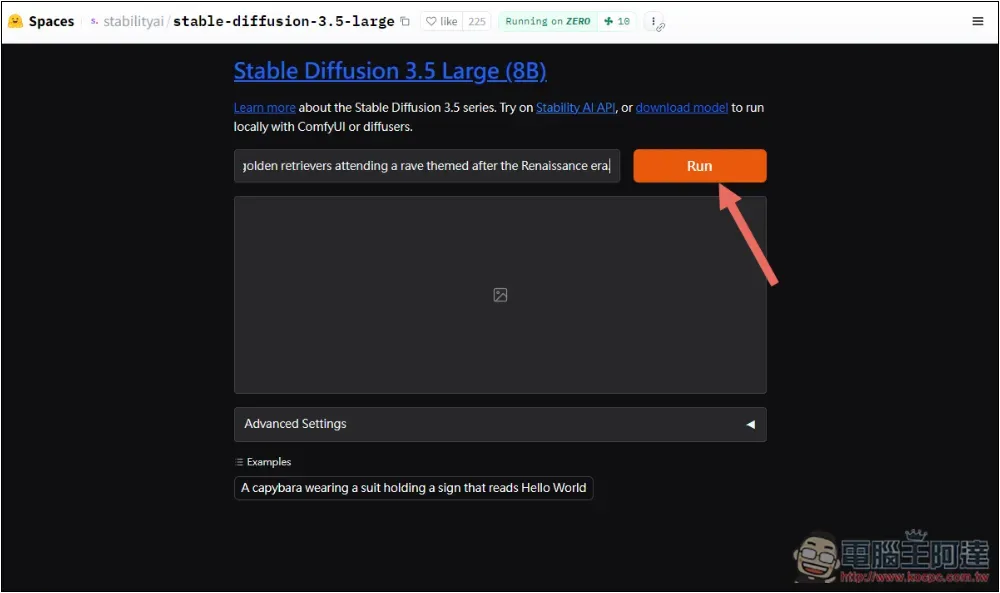

二款的使用介面都一樣,點擊上方連結進到 Hugging Face 頁面後,就在輸入框中填入你要生成的 AI 圖描述 Prompt,然後按 Run:

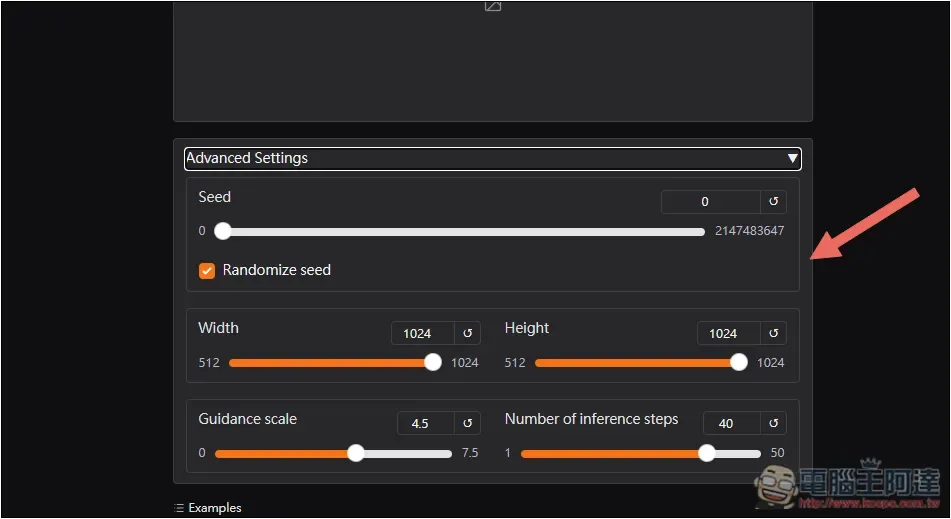

下方的進階設置,可以調整 Seed 數值、圖片寬度和高度等:

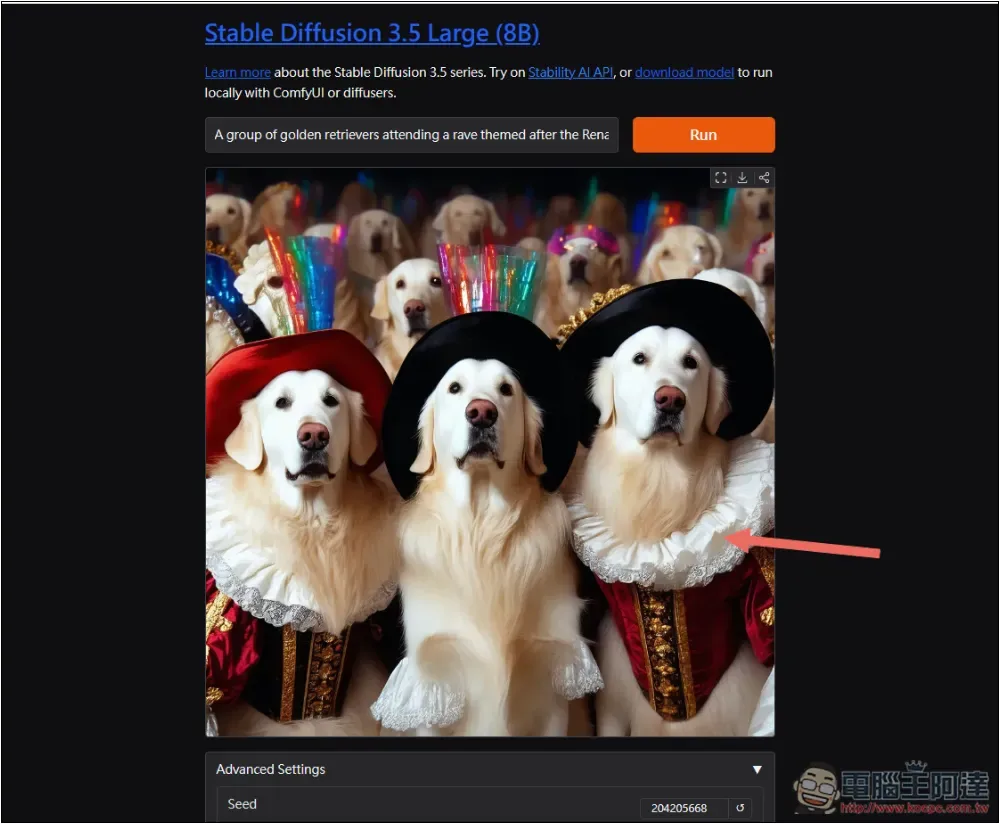

等待幾秒鐘的時間,就會獲得結果:

如何在本地安裝使用 Stable Diffusion 3.5

在本地使用 Stable Diffusion 3.5 有很多種方法,這邊我示範搭配 ComfyUI 軟體實現。

首先需要下載這幾個檔案:

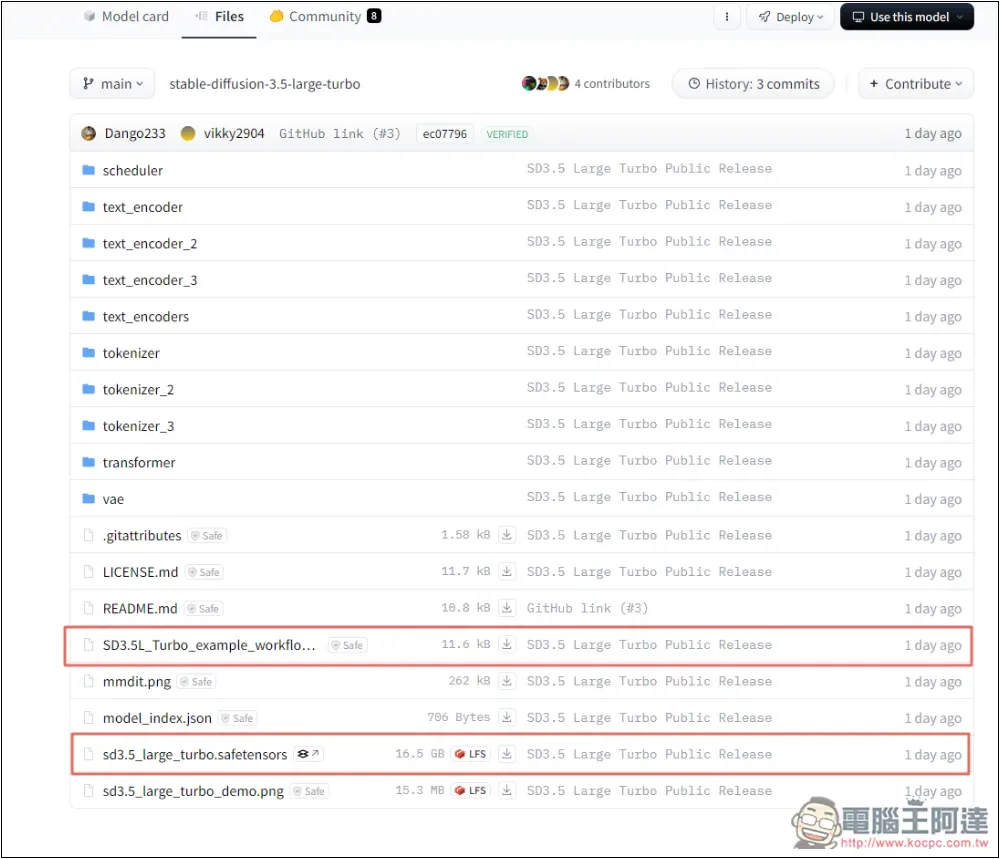

- 模型檔:Stable Diffusion 3.5 Large、Stable Diffusion 3.5 Large Turbo

- 工作區官方樣版:SD3.5L_example_workflow.json

- ComfyUI 軟體

- CLIP 檔案:clip_l.safetensors、clip_g.safetensors、(t5xxl_fp16.safetensors / t5xxl_fp8_e4m3fn.safetensors)

t5xxl 選一個載就好,如果你是下載 Large 模型,就下載 fp16,Large Turbo 則推薦用 fp8。詳細操作步驟如下。

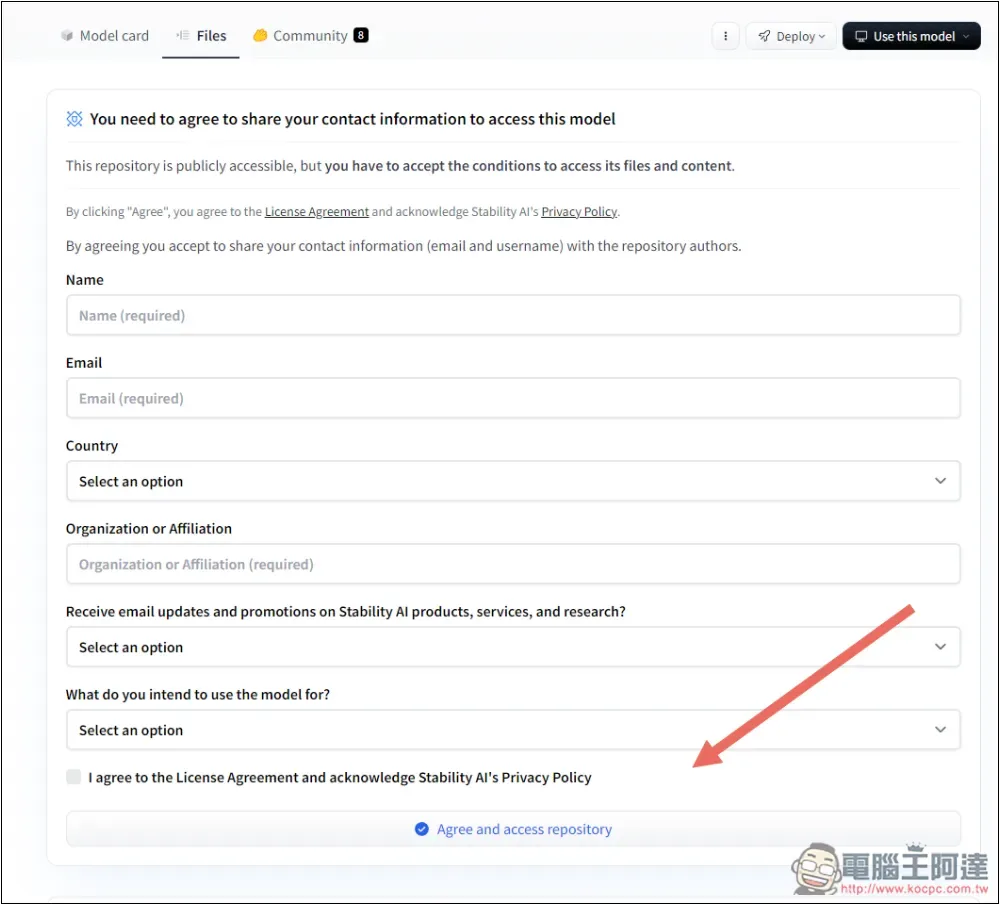

點擊上方連結進到模型檔下載頁面後,首次應該會要求你輸入一些資訊來使用這模型,也需要有 Hugging Face 帳號,沒有的話就免費註冊一下:

輸入完後,下載你需要的模型檔,我是用 Large Turbo,SD3.5L_example_workflow.json 是官方提供的工作區樣版,按右邊的下載圖示即可下載。另外我上面附的連結是進到該模型檔的下載頁面,你可以按左上角 Download 下載:

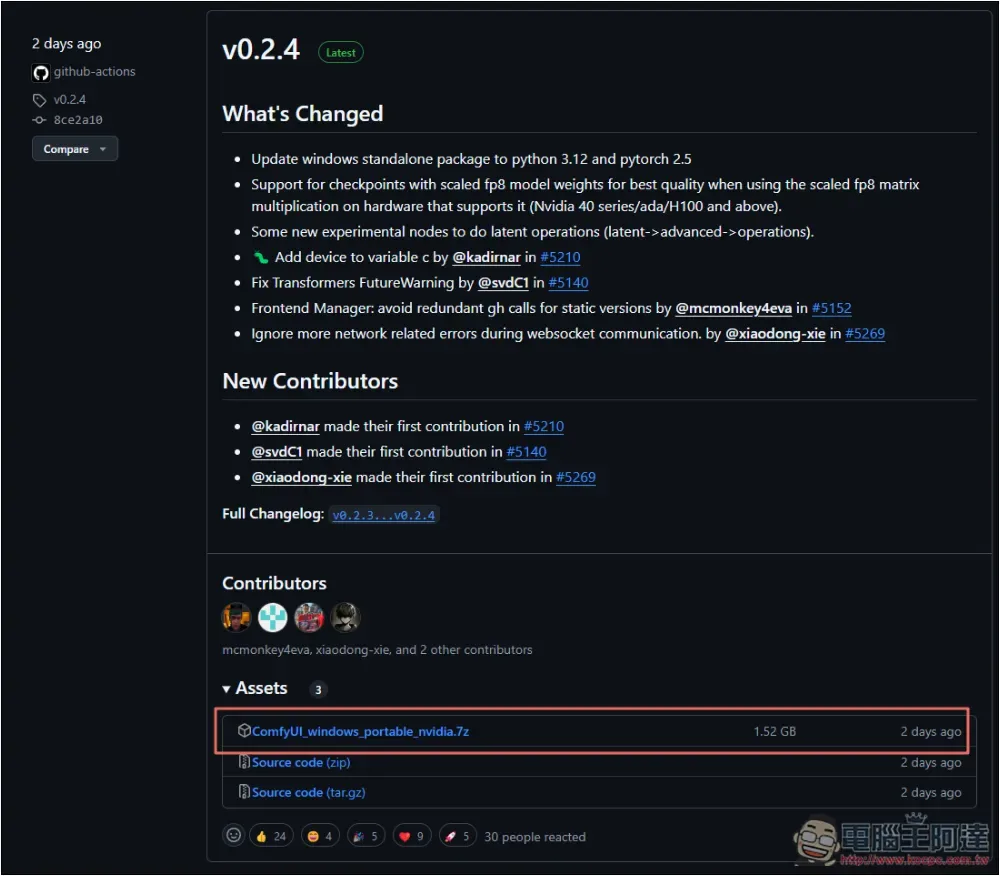

再來是 ComfyUI 軟體,目前最新版是 v0.2.4,下載 .7z 壓縮檔這一個:

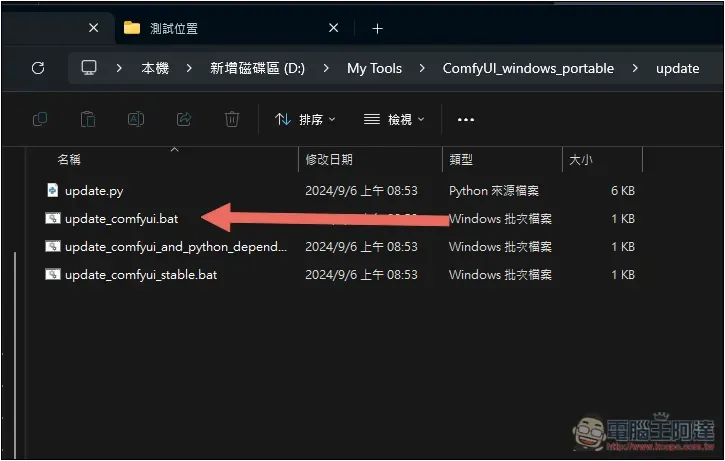

如果你本來就有 ComfyUI,記得升級到最新版,進到資料夾中的 update,按 update_comfyui.bat 就會開始更新:

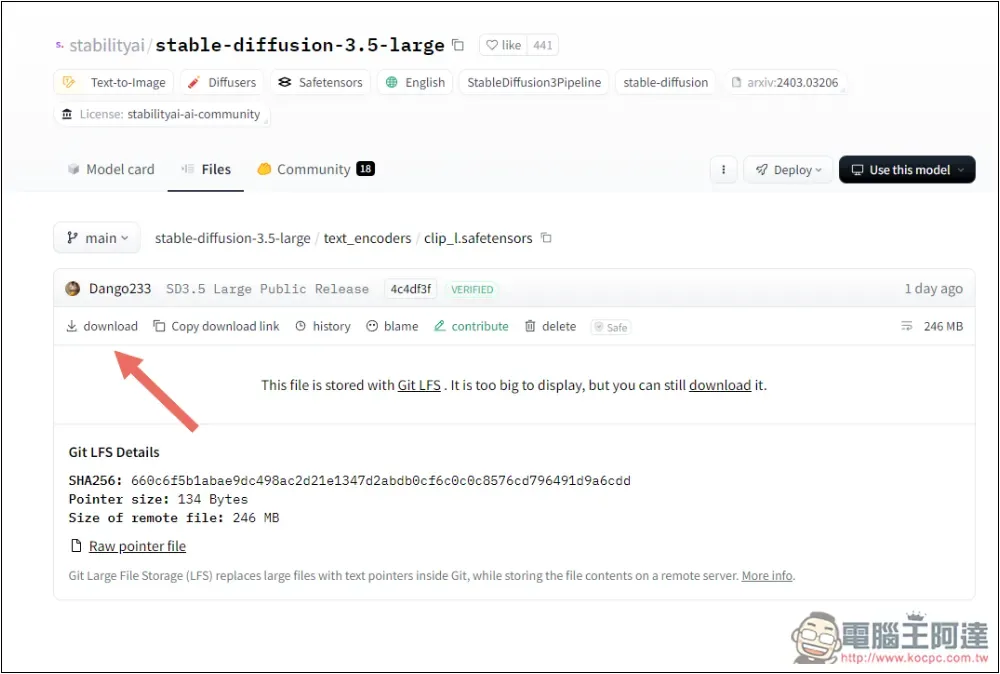

Clip 檔案總共需要 3 個,按上方連結進到下載頁面後,點左上方 download 即可下載:

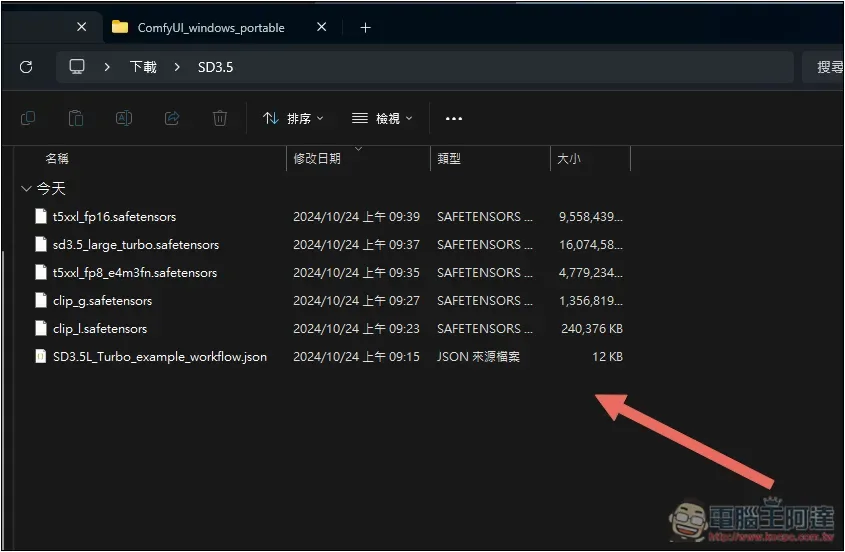

下載後的檔案建議放在同一個資料夾內,這樣等等要移動會比較容易。t5xxl 我 2 個都下載,所以才會多 1 個,正常來說總共有 5 個(不包含 ComfyUI):

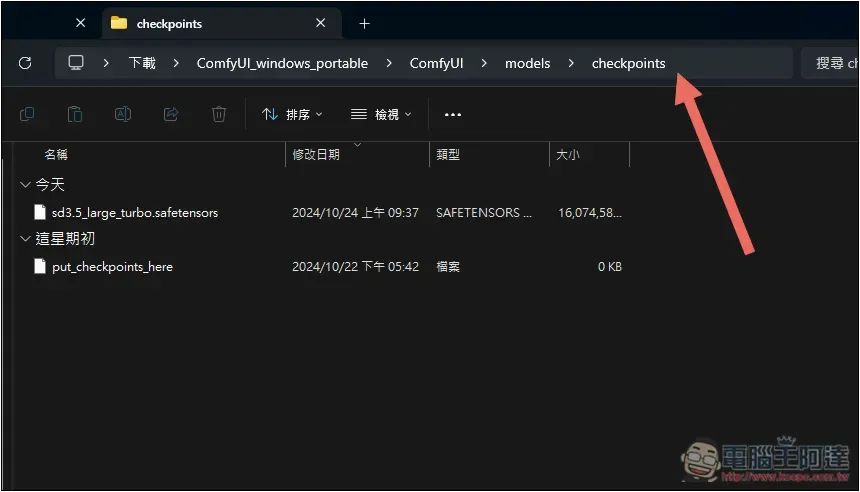

ComfyUI 下載好後解壓縮並打開,進到 ComfyUI > models > checkponts 資料夾,把模型檔放在這,我的是 sd3.5_large_turbo.safetensors:

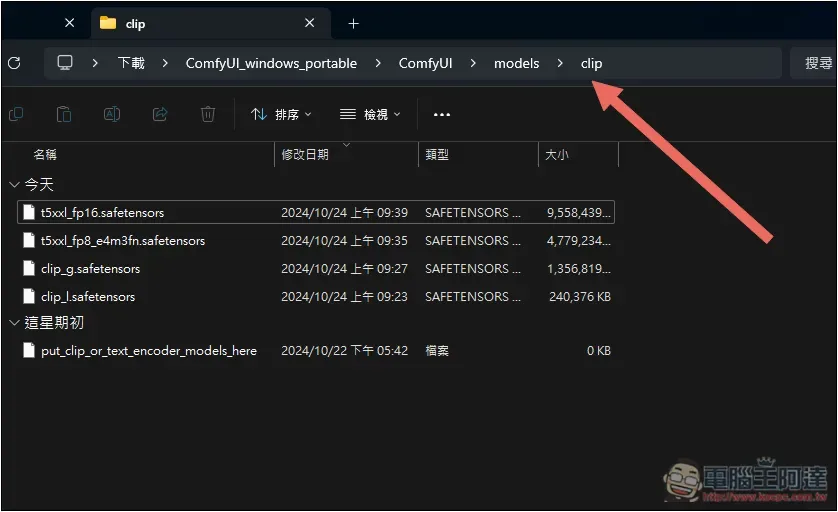

接著在進到 進到 ComfyUI > models > clip 資料夾,把下載好的 3 個 clip 檔案都放在這:

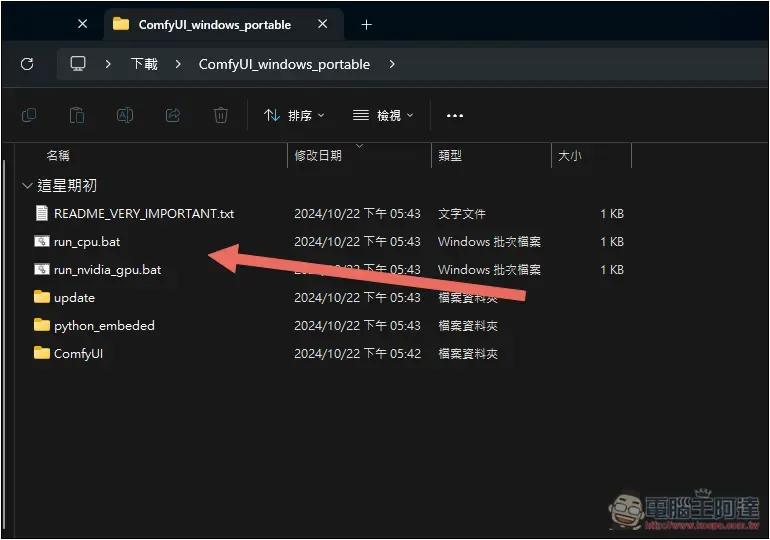

最後回到 ComfyUI_windows_portable 資料夾中啟用,有 NVIDIA 顯卡的人,請運行 run_nvida_gpu.bat,這樣在生成圖片時,才會使用顯卡進行運算,沒有的人則是 run_cpu.bat,CPU 運算速度會比較慢:

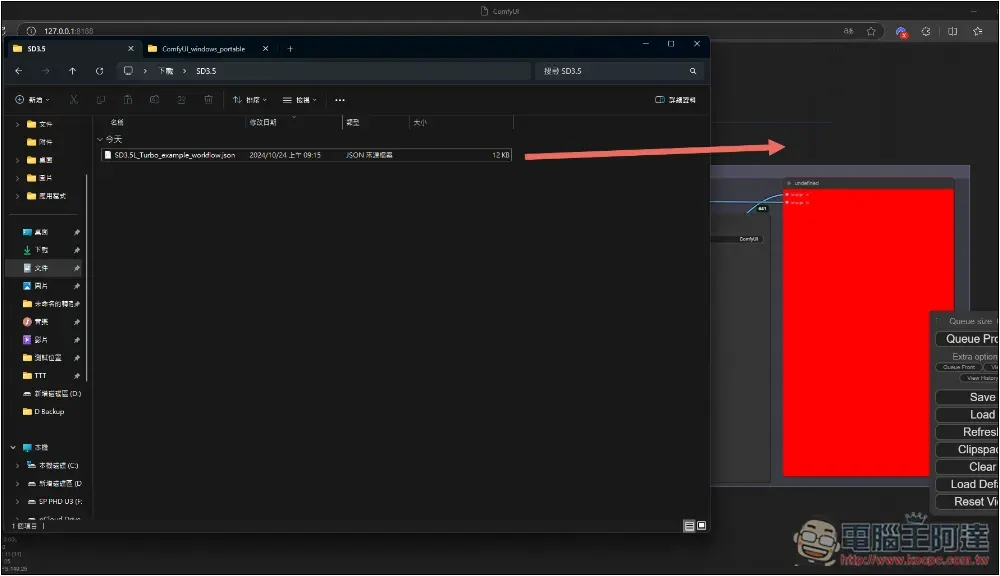

ComfyUI 打開後,把剛剛下載的工作區樣版 SD3.5L_example_workflow.json,拖曳放在 ComfyUI 畫面上方,這樣就會匯入了:

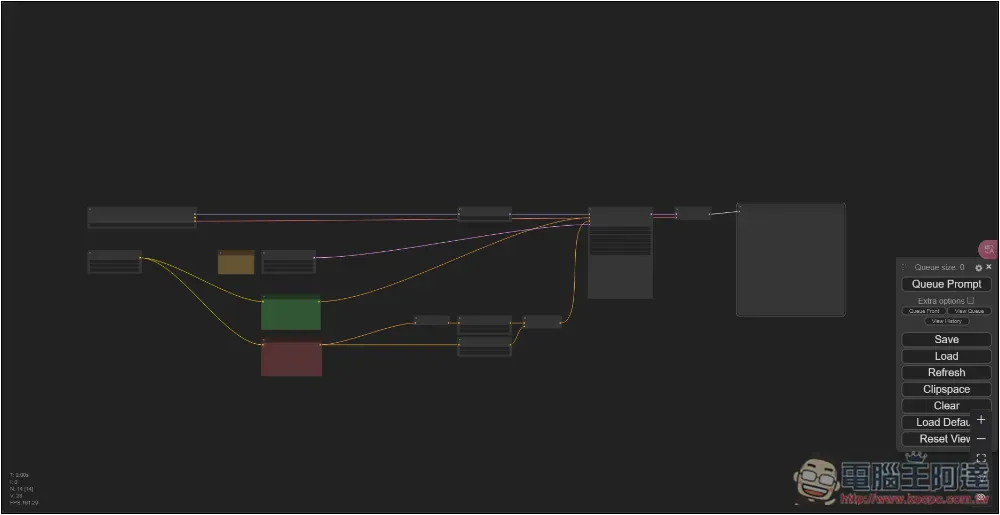

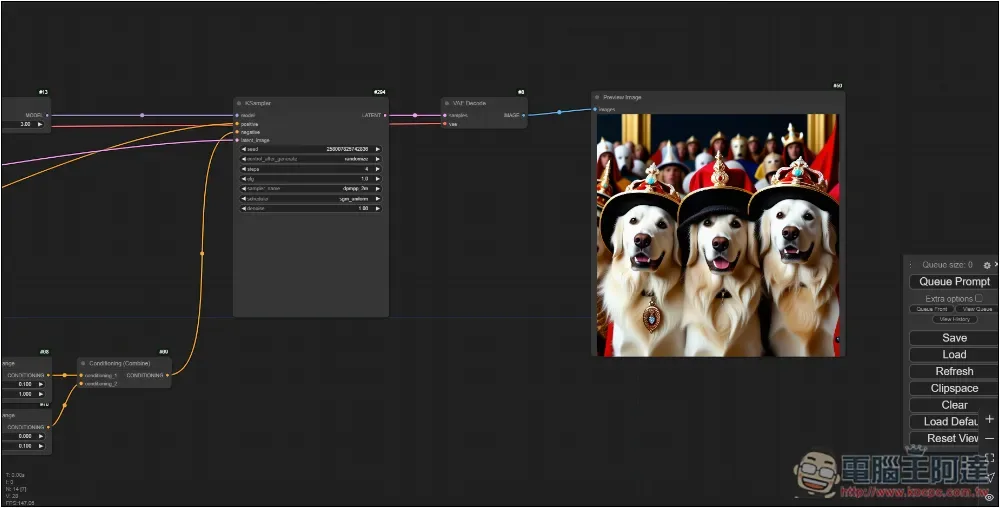

如下圖所示,目前因為畫面拉比較遠,所以才沒有任何字顯示,用滾輪滑進後就能看到:

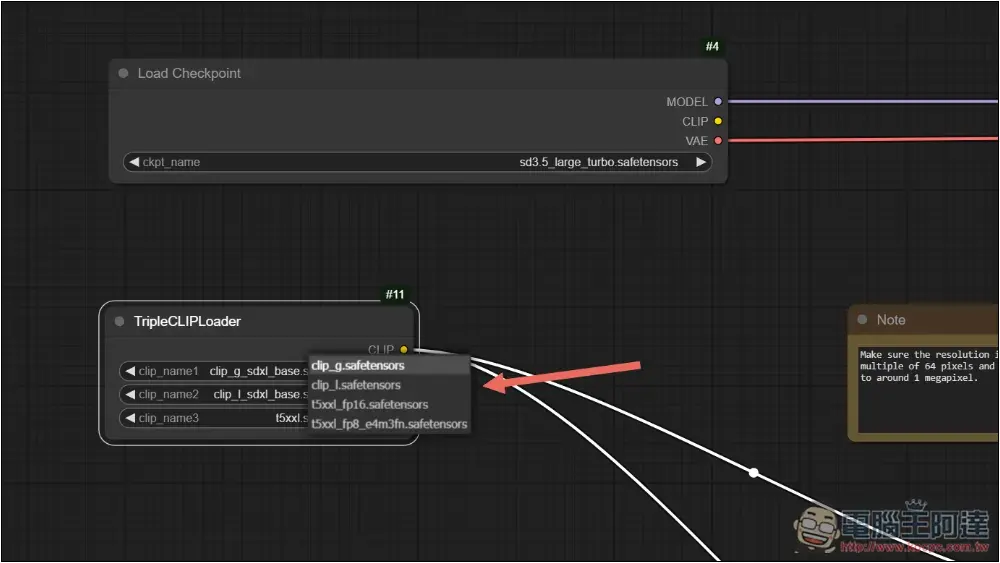

首先拉近到最左邊,Load Checkpoint 為模型設置,確認是不是你剛剛下載的那一個,沒問題後,TripleCLIPLoader 的三個選項需要改成剛剛下載的 clip 檔案:

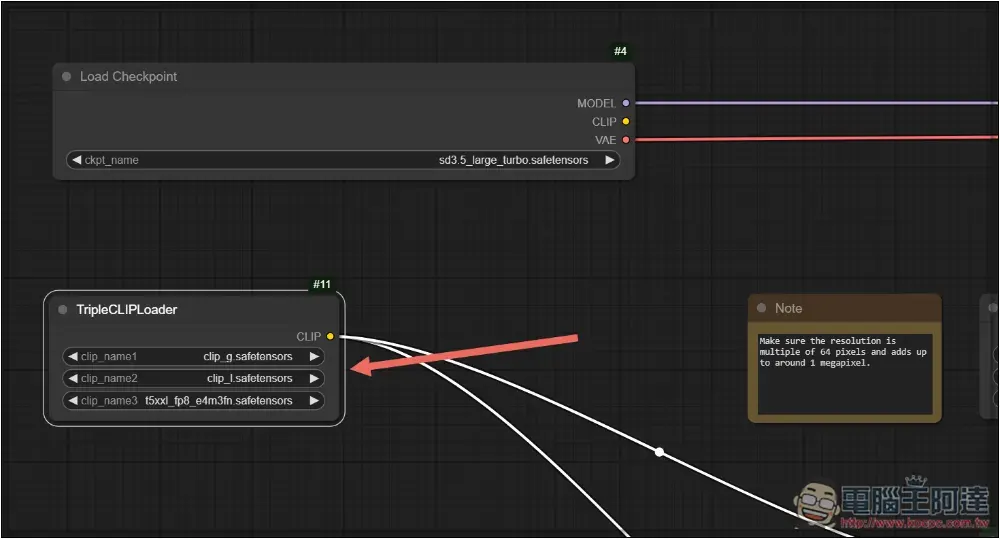

像這樣:

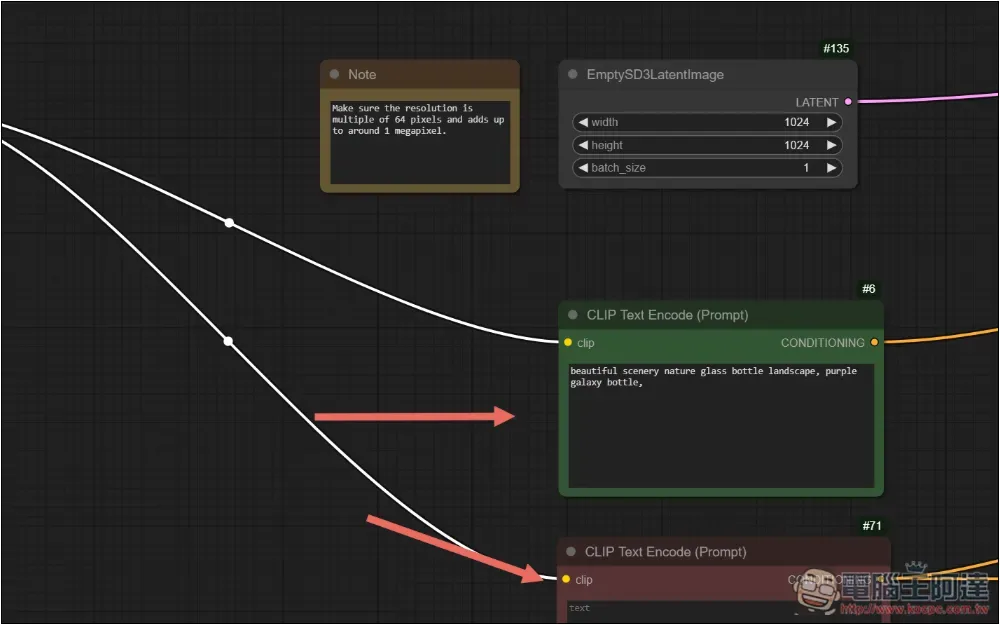

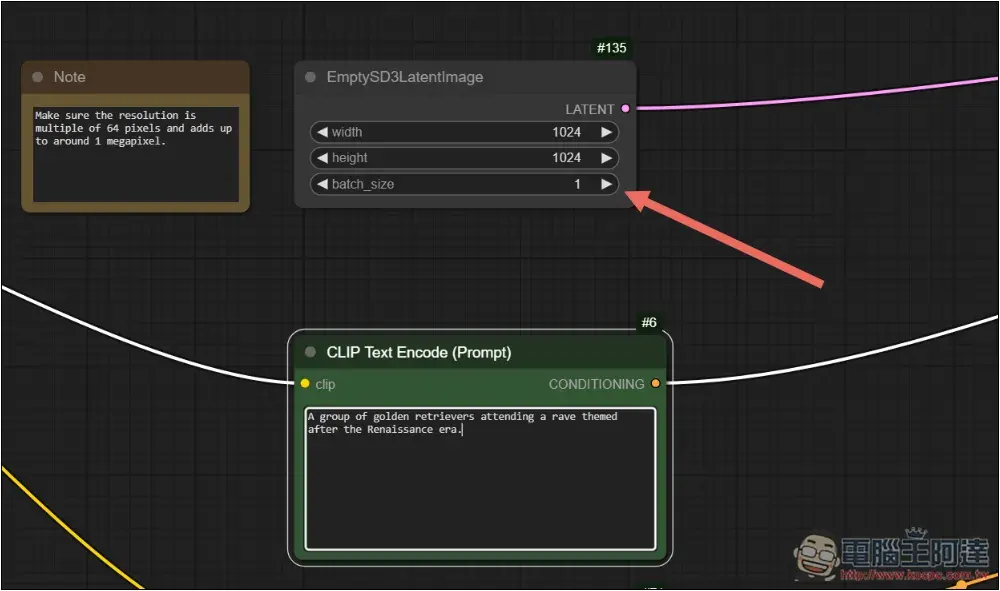

右邊綠色 CLIP Text Encode 就是輸入圖片 Prompt 的地方,已經有預設好,你可以先試試看能不能正常生成。下方紅色 CLIP 則是反面 Prompt,可輸入你不想出現在圖片上的內容:

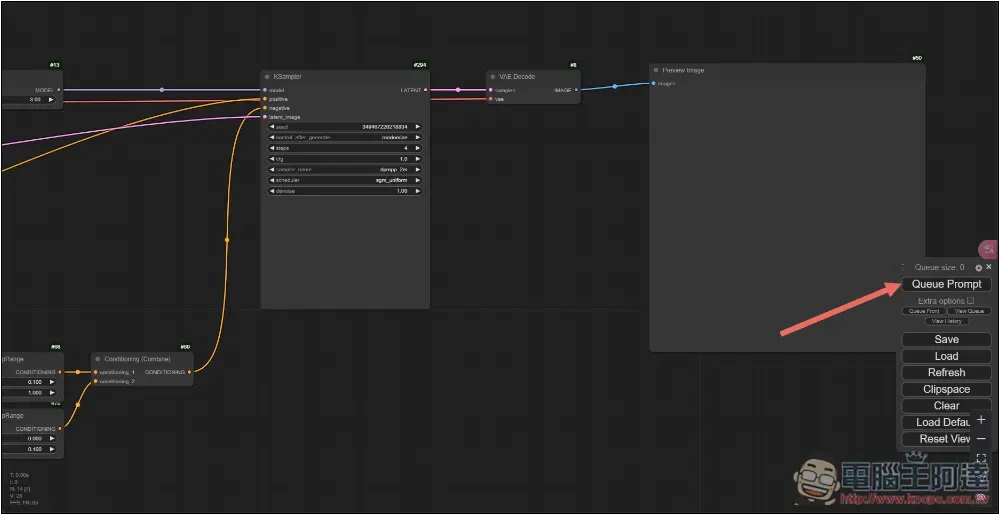

按右邊的 Queue Prompt 即可開始生成:

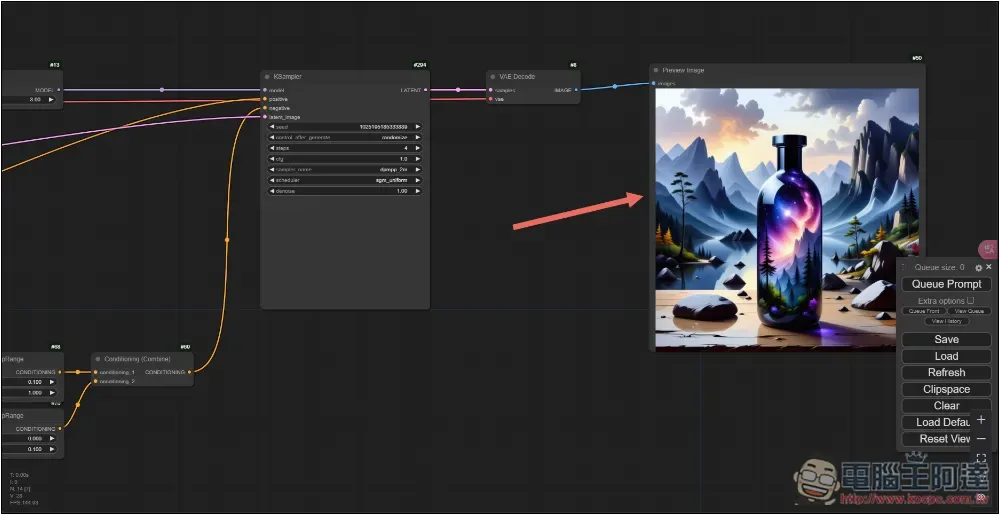

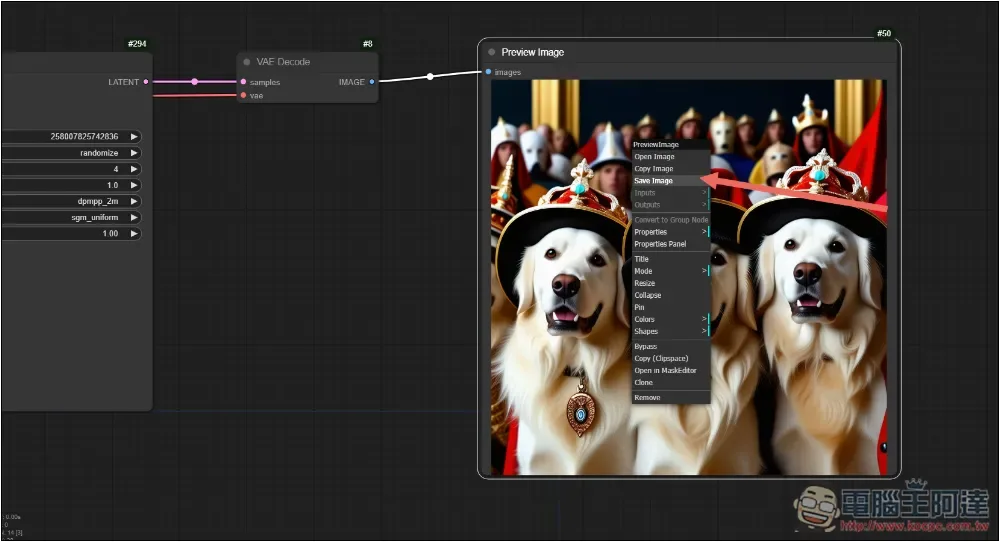

生成好後,最右邊的 Preview Image 就會顯示結果,生成速度取決於你的電腦硬體:

EmptySD3LatentImage 可設置你要生成的圖片高度、寬度、以及張數:

如果你對圖片滿意,在上方按滑鼠右邊,點 Save Image 即可將圖片儲存起來: