未來網路和電子商務的發展,大家都可以輕鬆在網路上獲取各種服裝信息。不過光是在網路上看照片很難想像實際上身的效果,所以最近越來越多公司在開發虛擬試衣技術,先前我們就介紹過阿里巴巴開發的虛擬試衣技術 Outfit Anyone。不過阿里巴巴認為有時光是把圖片換到模特身上這種靜態的展示方式有時也很難還原實際效果,特別有些衣服靜態和動態的效果又不一樣,阿里巴巴又與中國科技技術大學合作推出一款處理影片虛擬試穿任務的框架「 ViViD 」,使用 ViViD 的擴散模型來合成高質量的試穿影片。

服裝細節更逼真、動作更流暢 阿里巴巴開發處理影片虛擬試穿框架「 ViViD 」

阿里巴巴與中國科技技術大學合作開發處理影片虛擬試穿任務的框架「 ViViD 」, ViViD 的用途是讓目標服裝套用在目標人物的影片上時能夠保持原影片不變。

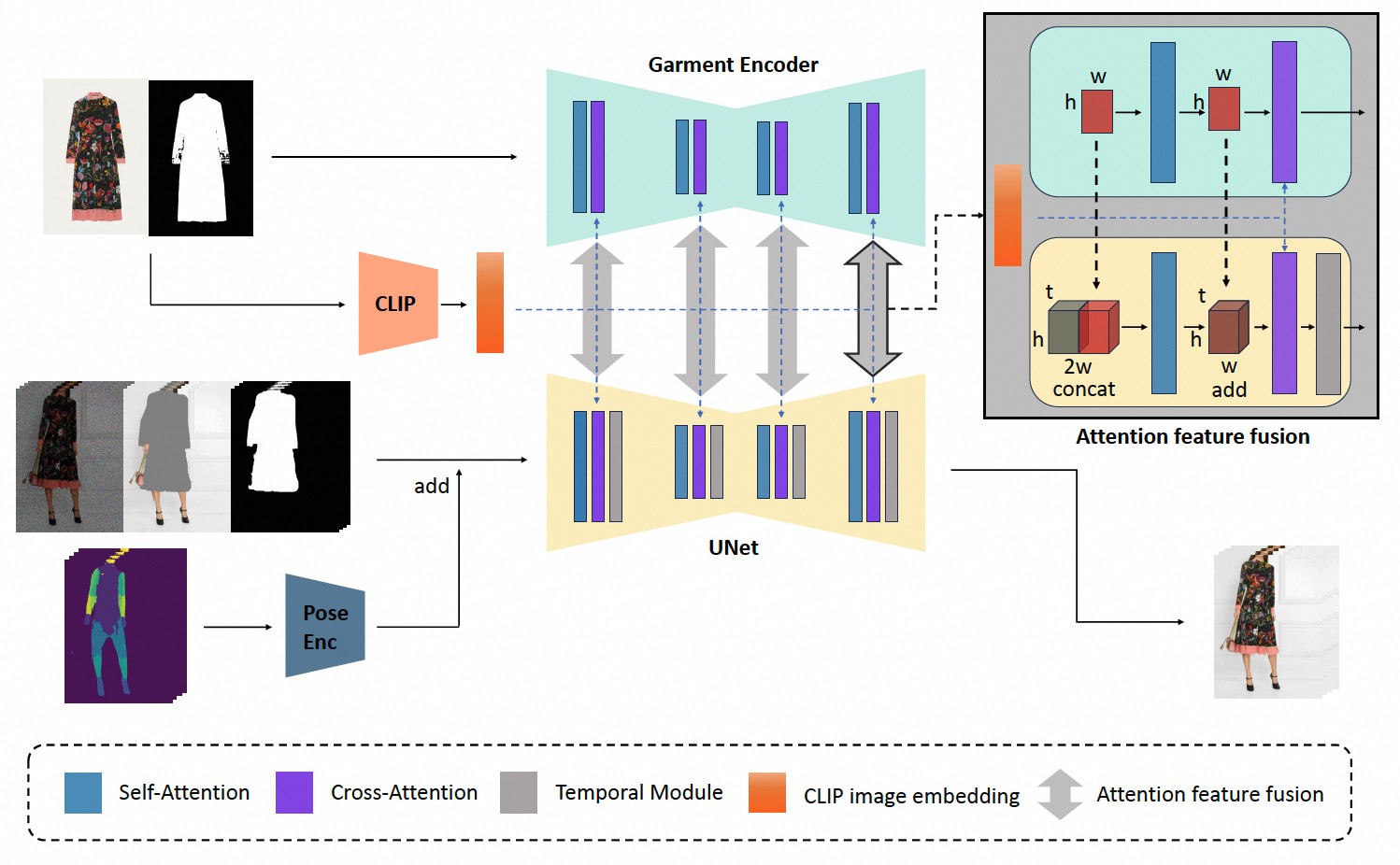

ViViD 的服裝編碼器 Garment Encoder 可以提取試穿服裝的衣物語意特徵,指導模型捕捉衣服細節並通過注意力特徵融合機制將要試穿的衣物放到目標影片裡面。

為了保持一致性,ViViD 還引入一個輕量級的姿勢編碼器 Pose Encoder 來編成姿勢信號,讓模型能夠學習衣物與人體姿勢之間的交互,再使用分層的時序模塊 Temporal Modules 插入文字到圖片的穩定擴散模型中,以此來實現連貫逼真的合成影片。

可以看到現在就算是試穿模特沒有露肩,換上露肩的衣服也不會有斷幀率的問題。現在 ViViD 總共有 9700 對試穿服裝和相應的高分辨率影片,數據集將服裝分為上身、下身和連衣裙三類,可以顯著提高影片虛擬試穿解決方案的性能和應用性。

阿里巴巴與中國科技技術大學合作開發處理影片虛擬試穿任務的框架「 ViViD 」也會開源,有興趣的朋友可以點擊這裡前往 GitHub 了解更多,想要了解更多有關 ViViD 技術的朋友也可以點擊這裡前往介紹頁面: