隨著 OpenAI 和 Google 都陸續推出 GPT-4o 和 Gemini 1.5 Pro 新版本模型,很多人一定會好奇,這二個到底誰比較強?雖然很明顯 GPT-4o 一定略勝一籌,但究竟是贏多少?近日就有外媒詳細測試了 8 項內容,最終顯示,Gemini 1.5 Pro 連 GPT-4 的車尾燈都看不到,沒想到差這麼多。

ChatGPT 4o 和 Gemini 1.5 Pro 誰比較強?外媒實測 8 項內容 ChatGPT 4o 完勝

外媒 Beebom 最近分享了 ChatGPT 4o 和 Gemini 1.5 Pro 的比較實測報告,共測試 8 個項目,分別是「計算毛巾的烘乾時間」、「魔術電梯測試」、「找到蘋果」、「哪一個更重?」、「遵循用戶指示」、「多模態圖片測試」、「字元識別測試」、以及「建立遊戲」。

在這些測試中,Gemini 1.5 Pro 沒有一個是獲勝的,意味著 ChatGPT 4o 全勝,不過有幾個測試項目是平手,也有二者都失敗的情況,也就是無優勝者。

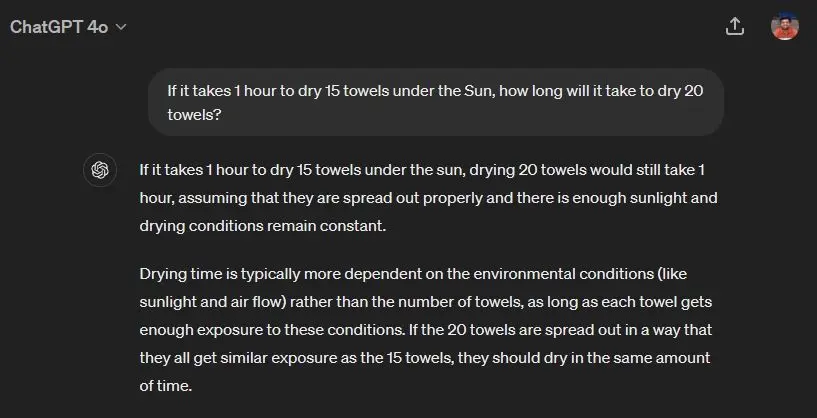

就以「計算毛巾的烘乾時間」來說,Beebom 的問題不算太困難:「15 條毛巾需要花 1 小時烘乾,那 20 條毛巾要花多久?」

針對這題,ChatGPT 4o 給出完美的答案,考量到現實情況,會跟 15 條毛巾差不多時間,並給出解釋:

圖片來源:Beebom

Gemini 1.5 Pro 就認為是數學問題,詳細計算出每一條毛巾需要烘乾多長時間,然後給出需要 80 分鐘的回答。由此可見,ChatGPT 4o 的推理能力非常不錯:

圖片來源:Beebom

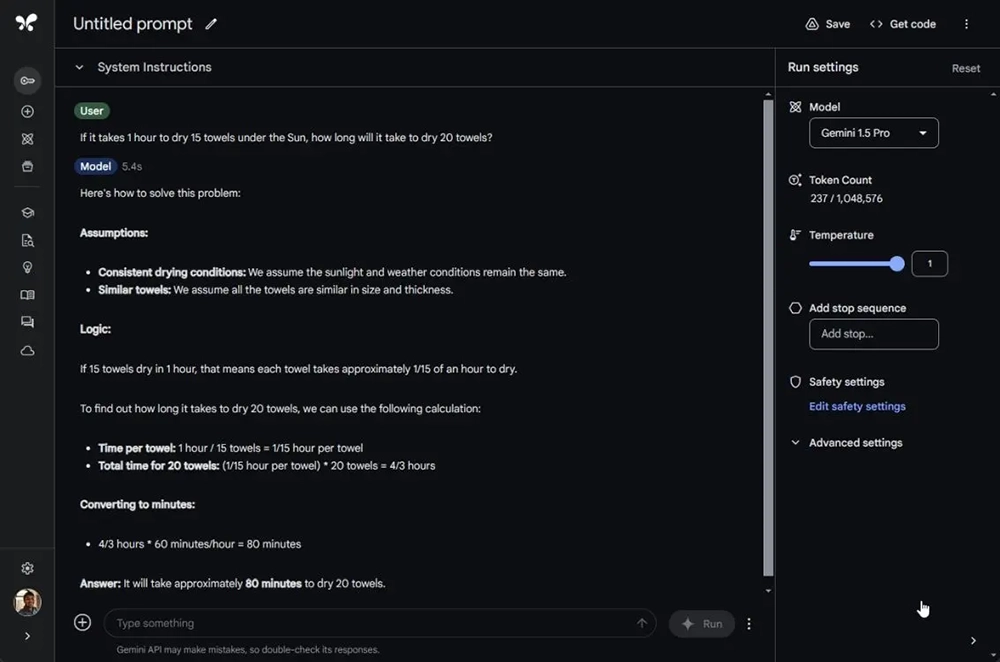

「找到蘋果」這項測試中,Beebom 問說「有一個沒有底部的籃子放在盒子裡,而這個盒子放在地上。我把三顆蘋果放進籃子裡後,把籃子移到桌子上。那麼蘋果現在在哪裡呢?」

ChatGPT 4o 成功發現關鍵點「沒有底部的籃子」,因此給出蘋果會在地上的盒子裡面。而 Gemini 1.5 Pro 雖然也回答正確是在地上,但卻沒有提到盒子,因此 ChatGPT 4o 再次獲勝:

圖片來源:Beebom

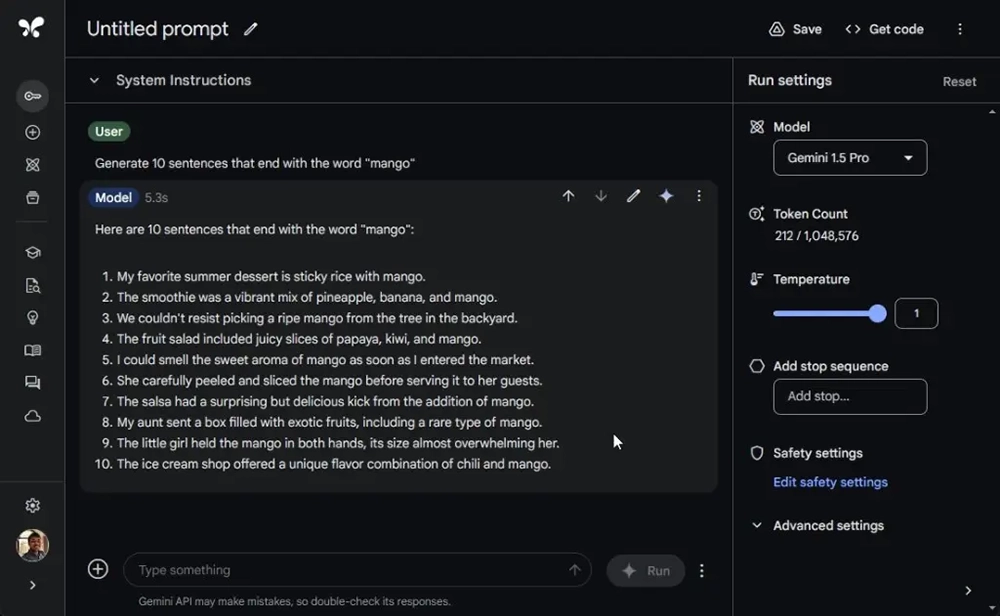

另外在「遵循用戶指示」測試中也顯示出,當回覆內容變長,Gemini 1.5 Pro 可能就不會根據用戶要求指示生成內容。Beebom 要求創建 10 個結尾是 mango 句子,Gemini 1.5 Pro 只有創建 6 個,另外 4 個 mango 都不是在結尾,ChatGPT 4o 則 10 個都是:

圖片來源:Beebom

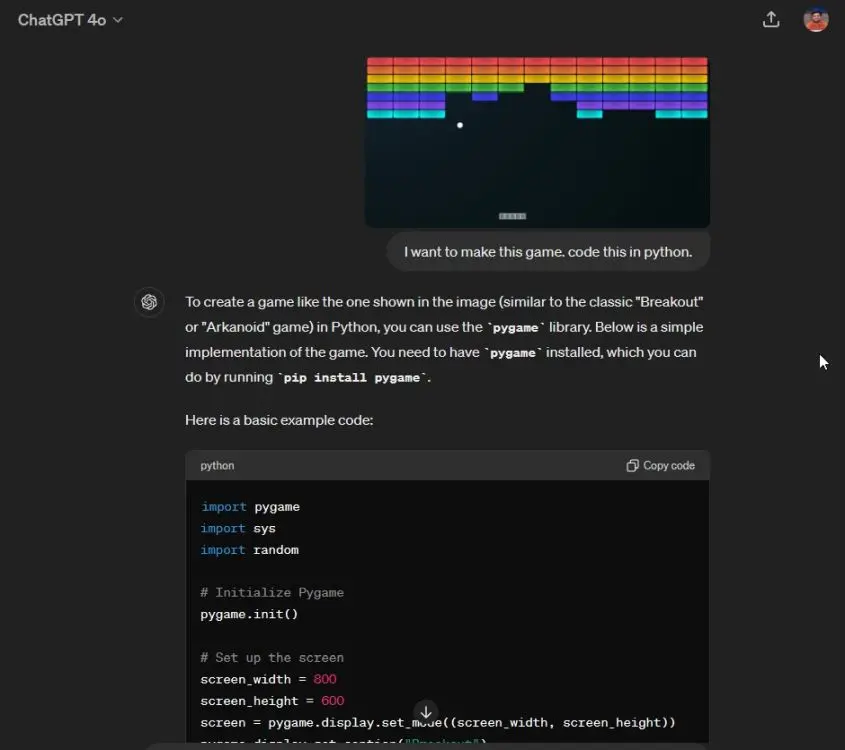

「建立遊戲」這一個很多人應該都有興趣知道,測試 ChatGPT 4o 和 Gemini 1.5 Pro 的寫程式和創作能力。

題目很簡單,就只有給一張圖片和要求建立遊戲,ChatGPT 4o 很快就生成出相關程式碼,Beebom 透過 pip 安裝並使用 Python 執行,遊戲成功啟動,沒有任何錯誤,這可說讓人非常驚艷。

Gemini 1.5 Pro 雖然也成功生成出遊戲程式碼,但啟動時視窗會一直關閉,無法玩,由此可見 ChatGPT 4o 寫程式能力更加可靠:

圖片來源:Beebom

整體來看,Gemini 1.5 Pro 的能力目前還遠落後 ChatGPT 4o,但也不是沒優點,Gemini 1.5 Pro 目前支援到 200 萬個 tokens。