高通在上週於舊金山的 AI OPEN DAY 活動中推出針對雲端運算加速應用而生的 Qualcomm Cloud AI 100 處理器,這次在深圳中也同時進行發佈,與終端裝置使用的 Snapdragon 665、730、730G 系列不同,Qualcomm Cloud AI 100 是專門處理海量終端資料進行 AI 處理的輔助處理器,搭配將來的 5G 網路達到最大的 AI 巨量資料處理目的。

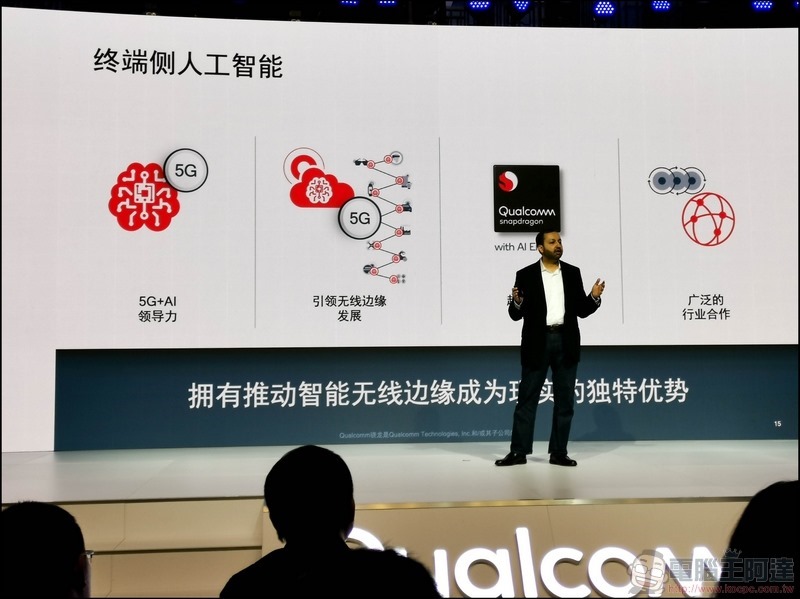

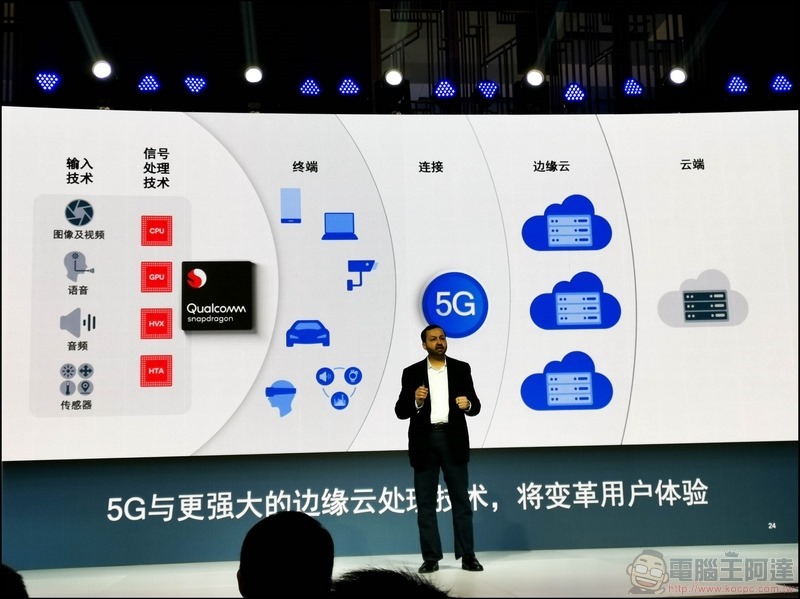

高通技術產品管理副總裁 Ziad Asghar 表示「無線邊緣」(這名詞泛指各種無線終端設施,包括手機、汽車、智慧穿戴、物聯網設施…等等)的巨量資料可實現 5G+AI 的全部潛力:

高通的主要專長就是在工藝製程(S820為14nm,到S855時已經進展到7nm)、低功耗表現(ARM架構優勢)、規模化(一年七億顆處理器銷售)與各種信號處理(拍照、視頻、音頻、XR、手勢…)的技術優勢:

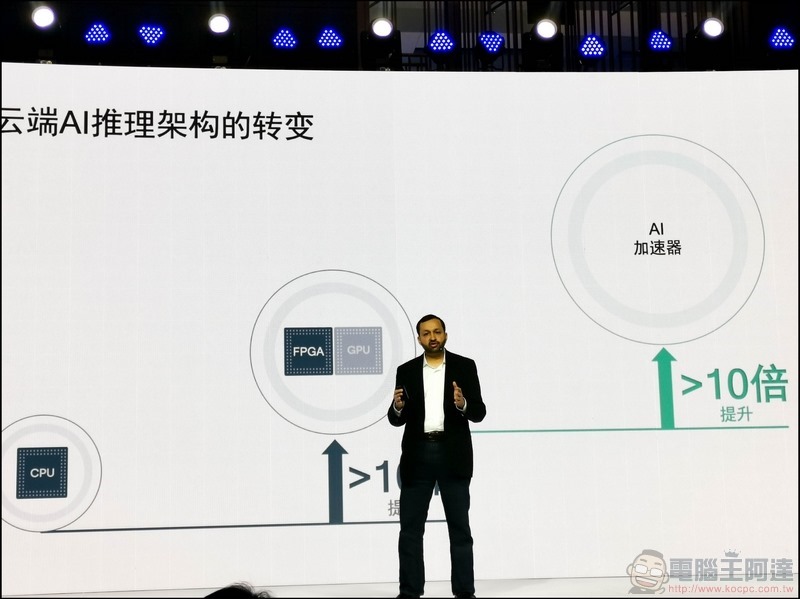

而雲端 AI 資料處理的架構由傳統的處理器到 FPGA架構處理器搭配GPU 的運算效能已有10倍的提升,而像 AI 100 這類的 AI 加速器能夠有多超過10倍的效能提升:

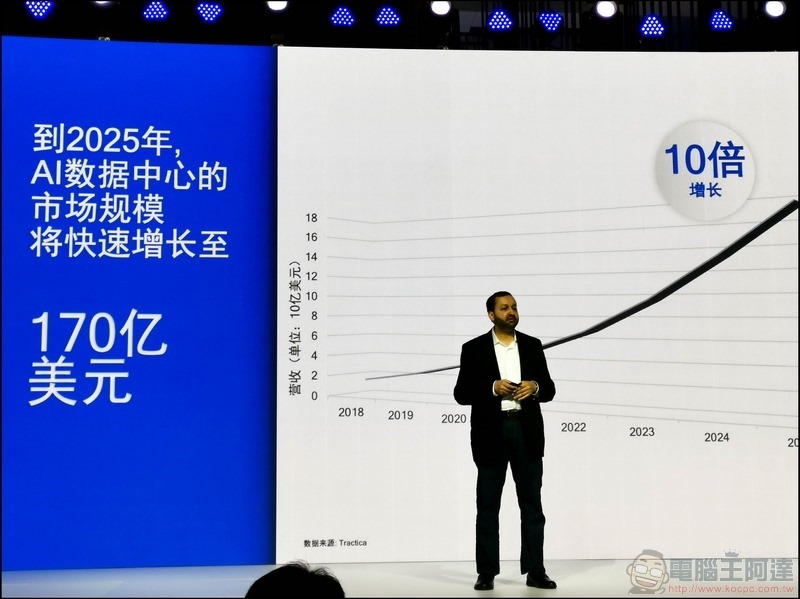

預估到2025年,全球 AI數據中心的規模將達 170億美金之譜:

而高通要做的就是將 AI 運算的海量需求由終端的手機透過 5G 大頻寬連接到雲端,經過高速運算後再將結果回傳到末端設備中:

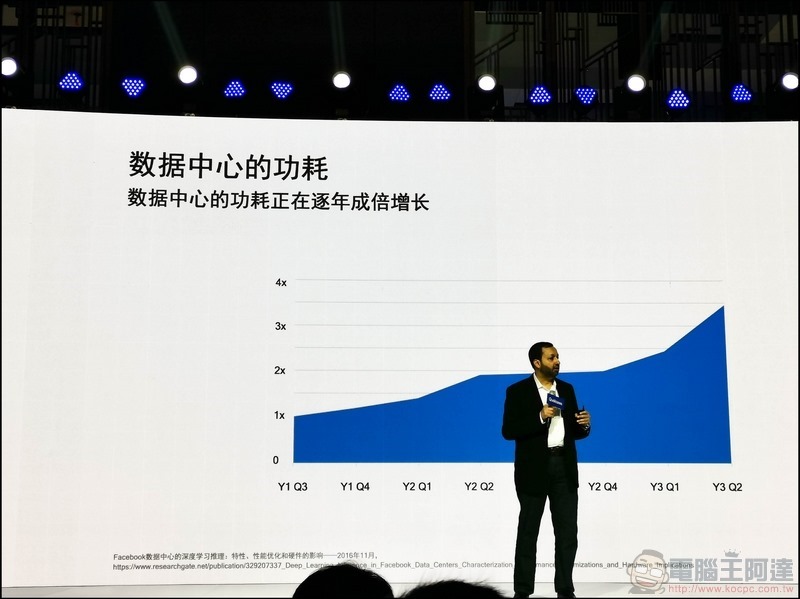

舉例來說,臉書內建的翻譯功能(大家只要看到其他語言的FB貼文下方就有一個翻譯提示),每天的翻譯量高達 59.5 億次。更別說其他類似的大型公司,如微軟、Google等公司,每天所花費在XR(VR、AR、MR)、自然語言處理(語音辨識、翻譯、電腦視覺)相關巨量 AI 運算的資源相當可觀,所以低功耗高算力的 AI 輔助處理器就相當重要:

這樣的巨量需求相當的可觀與耗費主機運算資源與電力消耗,每年也成倍數成長,但只要外掛 Qualcomm Cloud AI 100 這類的 AI 加速處理器,就能將大量的 AI 運算轉給 AI 100 處理,可大幅度的降低資訊中心的主機運算 Loading 與功耗:

看這段影片大家比較容易瞭解 Qualcomm Cloud AI 100 究竟在處理哪些海量 AI 資訊:

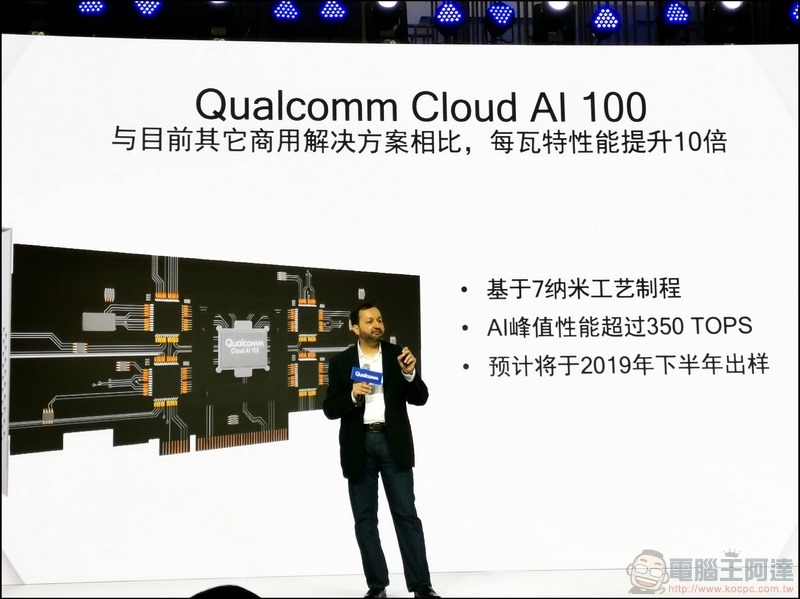

Qualcomm Cloud AI 100 加速處理器相容ONNX、Glow、XLA,以及包含TensorFlow、PyTorch、Keras、MXNet、PaddlePaddle等市面常見框架,降低服務開發難度與時間:

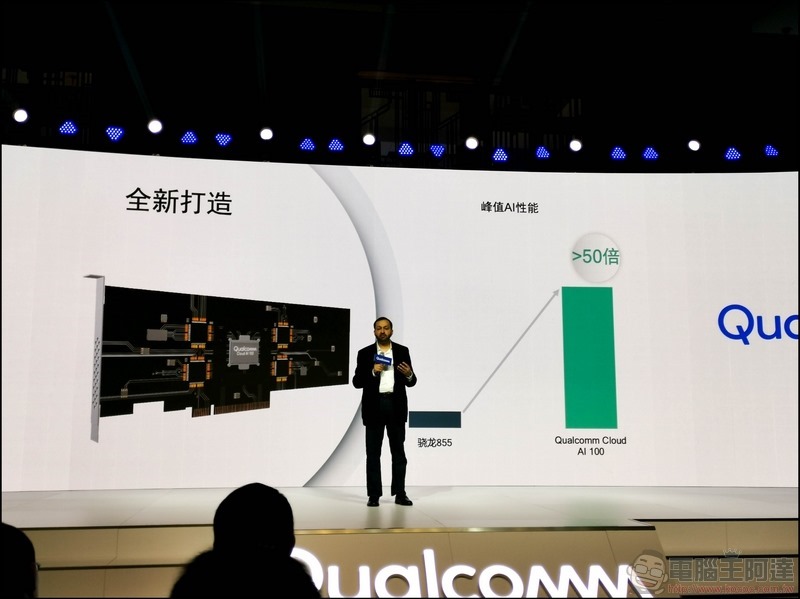

以 AI 算力來說的話 Qualcomm Cloud AI 100 的峰值運算效能是目前高通最強處理器 Snapdragon 855 的 50 倍以上,而且具備高擴展性可以多卡堆疊同步運算,並可外掛到任何形式的資料中心中進行輔助運算:

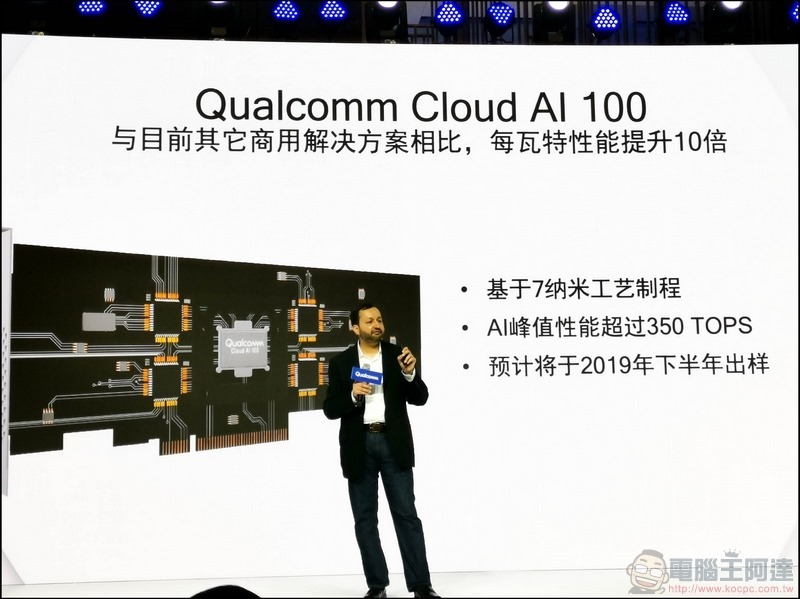

Qualcomm Cloud AI 100 採用7奈米製程設計,與目前市面上其他的商用方案(如 NVIDIA、Google)相比,每瓦特功耗的所發揮的性能提升十倍,AI 運算性能峰值超過 350 TOPs(每秒兆次運算),相當驚人!Qualcomm Cloud AI 100 處理器預計在 2019年下半提供樣品,2020年上市屆時應該會有許多商用的資料中心使用: