這幾年中國的 AI 模型可說越來越多,除了大家熟悉的 DeepSeek、Qwen 等之外,小米也正式加入戰場,稍早於社群平台中宣布,開源首個 Xiaomi MiMo 推理大模型,不僅提供多種版本,其 7B-RL 的數學推理和程式碼測試部份,得分還優於 OpenAI o1-mini、Qwen 的 QwQ-32B,可說相當不錯,目前所有參數模型都已經在 Hugging Face 上架。

小米首個 Xiaomi MiMo 推理大模型登場,共有 4 種模型

小米大模型稍早在微信平台上宣布開源首個為推理而生的大模型 Xiaomi MiMo,雖然小米稱 “大”,但實際上參數跟其他競爭對手相比,算是小很多,只有 70 億參數,但部份效能還是超越其他更大的語言模型。

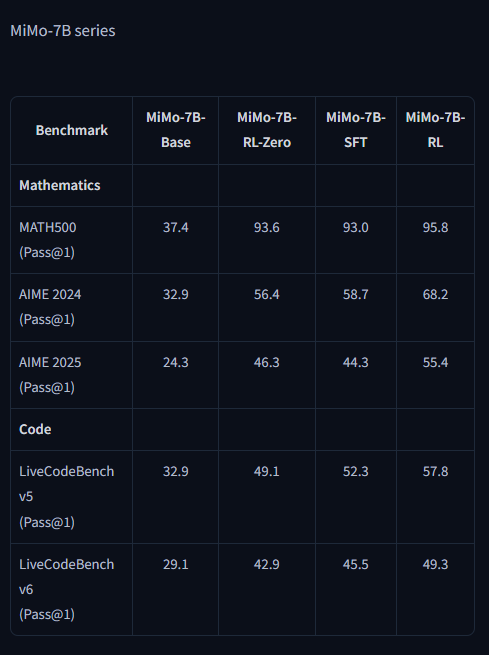

Xiaomi MiMo 共有 4 個版本,分別是:

- Mimo-7B-Base:預訓練模型

- Mimo-7B-SFT:監督微調模型

- Mimo-7B-RL、Mimo-7B-RL-Zero:強化學習模型

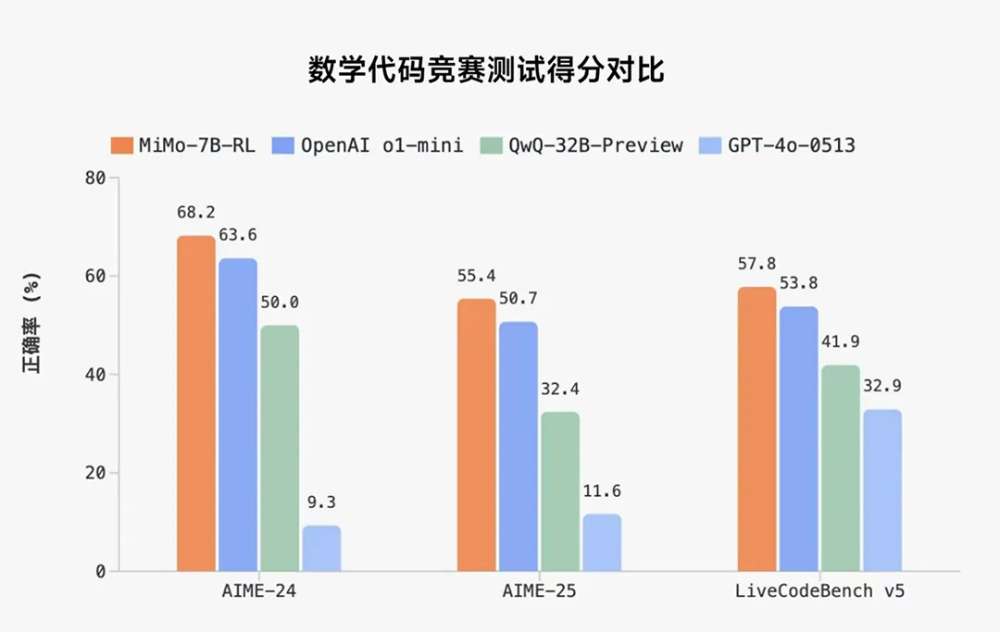

下方是小米分享的測試數據,有 AIME-24、AIME-25、與 LiveCodeBench v5 三項測試成績,分別是數學推理和程式碼競賽:

可以看到,MiMo-7B-RL 在這三項測試中,都領先競爭對手 OpenAI o1-mini 和 GPT-4o-0513、Qwen 的 QwQ-32B-Preview,7B 就擊敗 32B 模型,這點可說非常亮眼,而且領先分數還不少。

像是 AIME-24 中,MiMo-7B-RL 以 68.2 分的成績,領先 QwQ-32B-Preview 的 50 分達 36.4%。AIME-25 差距更來到 71%。

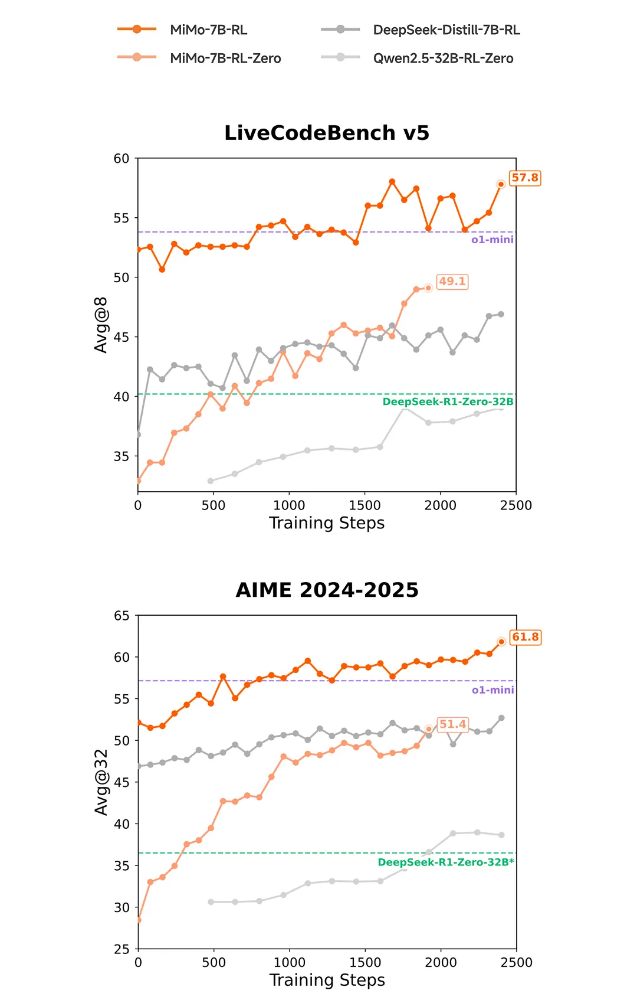

也有跟 DeepSeek 進行比較,同樣 70 億參數的 DeepSeek-R1-Distill-7B 模型,MiMo-7B 數學和程式碼領域的強化學習潛力也明顯領先:

小米還強調 MiMo 推理能力的提升,是由預訓練和後訓練階段中數據、算法等多層面創新聯合驅動

預訓練部份著重在讓模型看更多的推理模式,透過挖掘富推理語料,合成約 200B tokens 推理數據,透過三階段訓練來逐步提升難度,總訓練達到 25T tokens。後訓練核心則是高效穩定的強化學習算法和框架:

相關的技術報告,小米有放在 GitHub 網站上。對於有興趣玩玩看 MiMo-7B 四款開源模型的人,可至 Hugging Face 下載。

MiMo-7B 四款模型的跑分比較表,MiMo-7B-RL 數學和程式碼最強:

從小米一直強調數學和程式碼,基本上可以確定,MiMo-7B 模型大致上就只能用在這二個領域,其餘部份不要有太大期待。

資料來源:小米