受限於目前 iPhone 體積和技術,其 AI 運算能力當然沒有多好,也因此頂多只能運行 2B、4B 的 AI 模型,再往上就有可能跑不動,對於家中有電腦的人,一定會想知道有沒有方法可以遠端用電腦裡安裝的 AI 模型?不僅能跑更大參數的模型,還可以直接擁有電腦裡的知識庫。答案當然是有的,這篇就要來教你最簡單用 iPhone 搭配 LM Studio 的方式。

1. 電腦下載安裝 LM Studio 和你要用的模型

如果你的電腦裡還沒有 LM Studio,請先至官網下載,操作介面有中文,所以不用擔心看不懂的問題。

而模型部份就取決於你的電腦硬體規格,如果不知道怎麼挑,可以參考下載模型選單中的提示,左側第四個搜尋圖示就是下載模型選單(我使用 Power User 介面,底部可以切換):

接著輸入你想要使用的模型名稱,我以 Google 最新 Gemma 3 為例,有分 1B、4B、12B 和 27B 等參數,參數越大對效能要求越高。

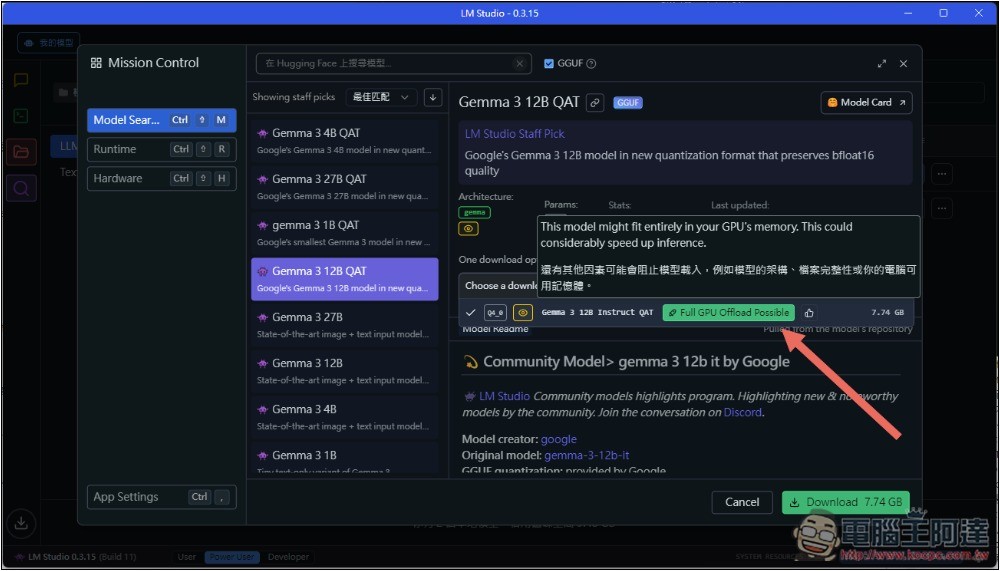

找到模型後,展開右側 One download option available 區塊,然後把滑鼠移到模型名字右邊的圖示,就會出現是否能完整使用你主要運算硬體的提示字,我的部分是 GPU,顯示 Full GPU Offload Possible,代表這參數模型可以完全跑在 GPU 上,所以基本上能運行順暢,我用 Gemma 3 12B QAT 沒問題:

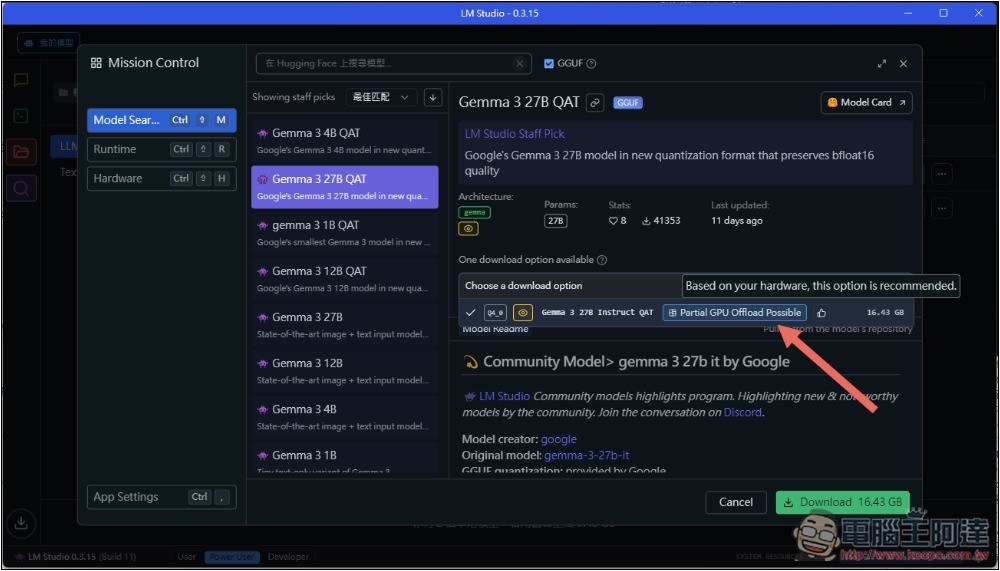

但改成 Gemma 3 27B QAT 後,變成 Partial GPU Offload Possible,只有部分可以,代表模型太大跑不動,這種就建議不用嘗試,一定很慢:

選好後按右下角 Download 按鈕,就會下載這模型。

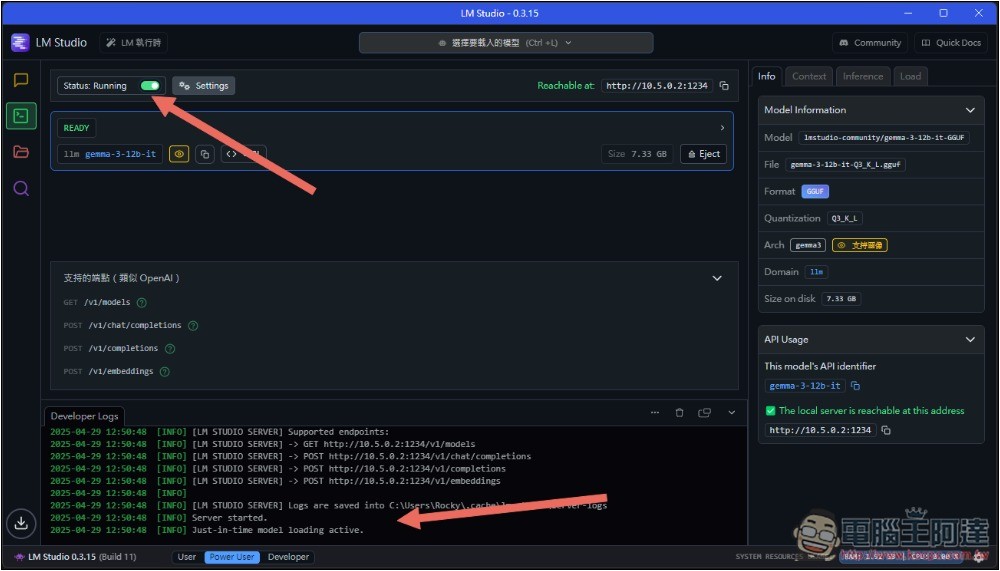

2. 啟用 LM Studio 的 Local LLM API Server

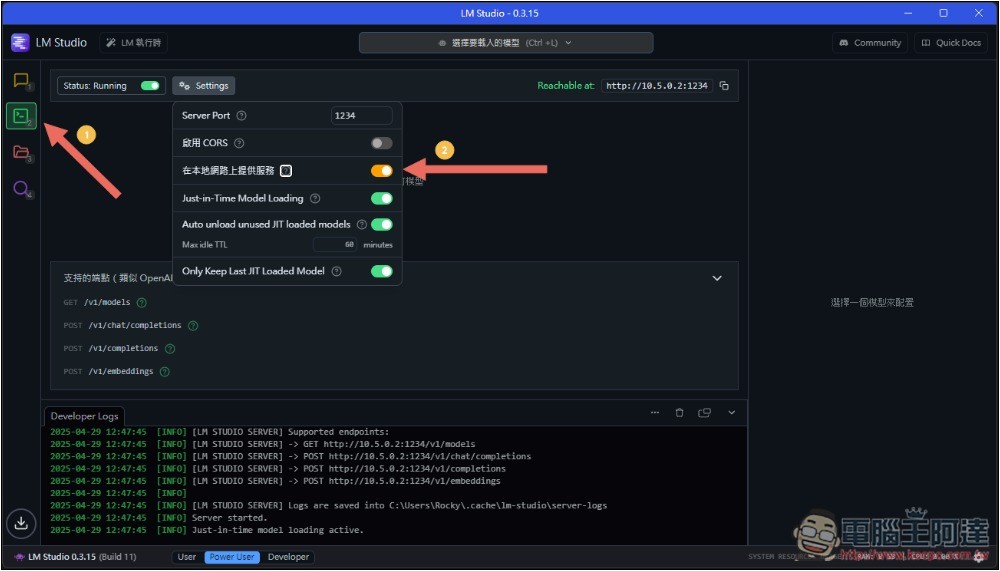

LM Studio 模型下載好後,接著是啟用 Local LLM API Server,左側第二個功能選單就是,然後有一點很重要,既然是要用 iPhone 遠端電腦裡的 LM Studio,一定要將 Settings 中的「在本地網路上提供服務」功能打開,沒打開就僅允許這台電腦使用:

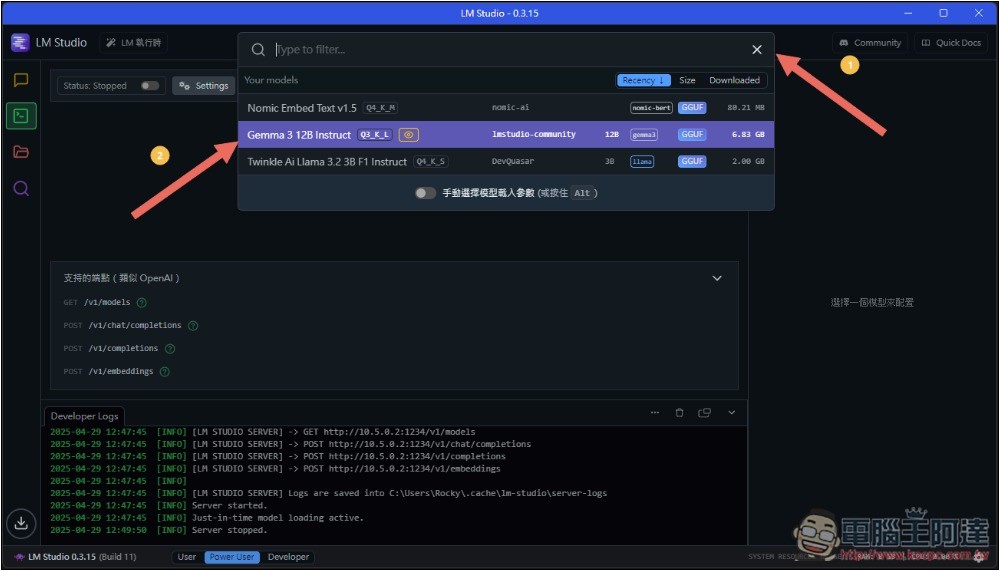

再來是將你要用的 LLM 模型掛載在 API Server,點一下就會掛載,顯示 READY 代表完成:

最後就是啟用 Server,打開上方的 Status,變成 Running 為開始運行,底部 Logs 日誌也會顯示 Server started:

電腦部份這樣就準備好了,接下來是 iPhone。

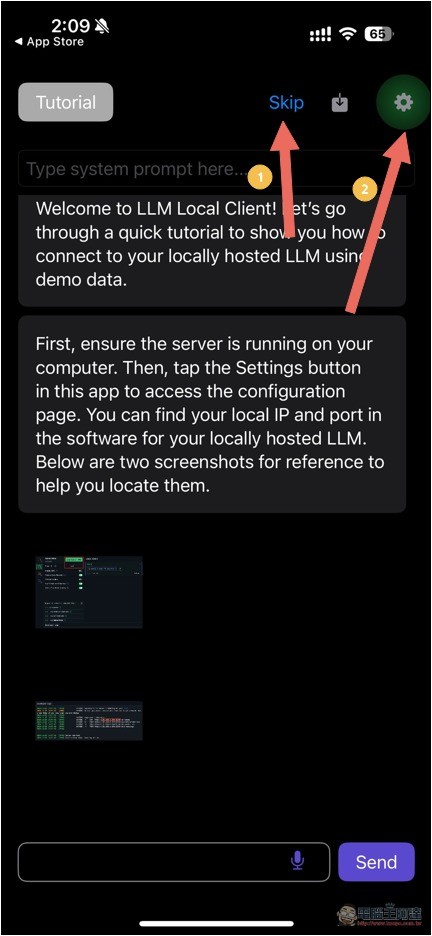

3. iPhone 下載 LLM Local Client

LLM Local Client 是一款免費的輕量級 App,主要用在讓手機或平板裝置透過本地網路(如 Wi-Fi),連接到電腦上已部署的 LLM 伺服器。

安裝完後打開,會顯示教學,不想看的人可以按 Skip 跳過,然後點右邊的設定圖示:

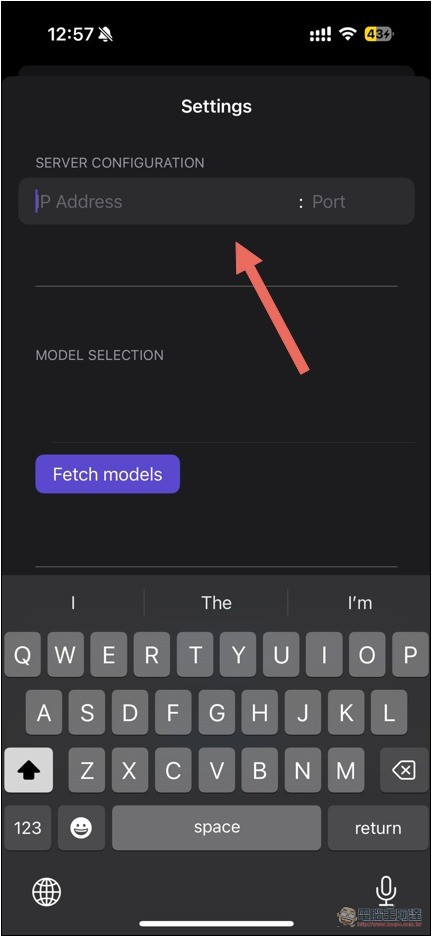

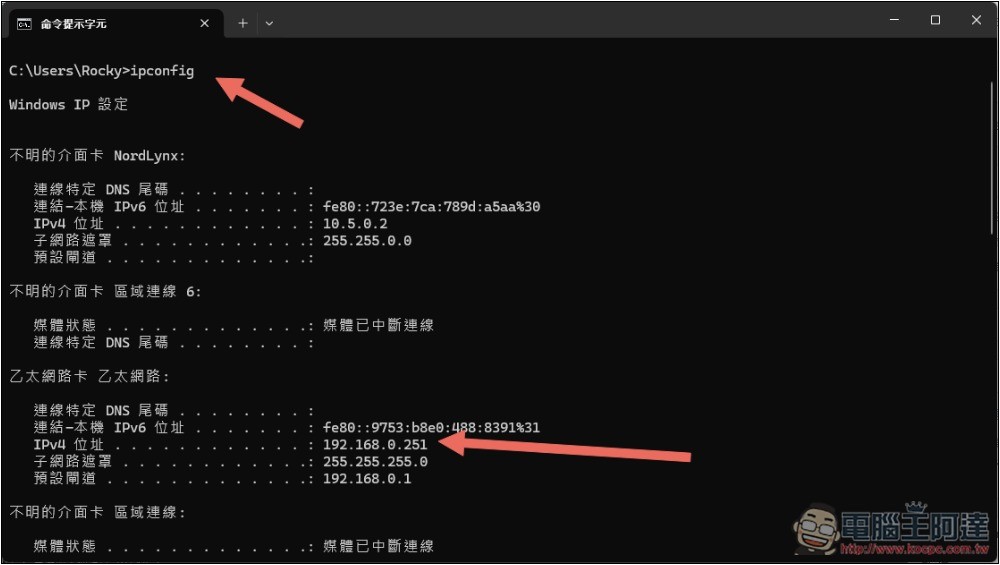

SERVER CONFIGURATION 需要輸入你電腦的 IP 地址,如果你不知道,可以在命令提示字元中查詢:

輸入 ipconfig 後,就會顯示電腦裡介面卡的資訊,我是使用乙太網路,因此 IPv4 位址這一個就是:

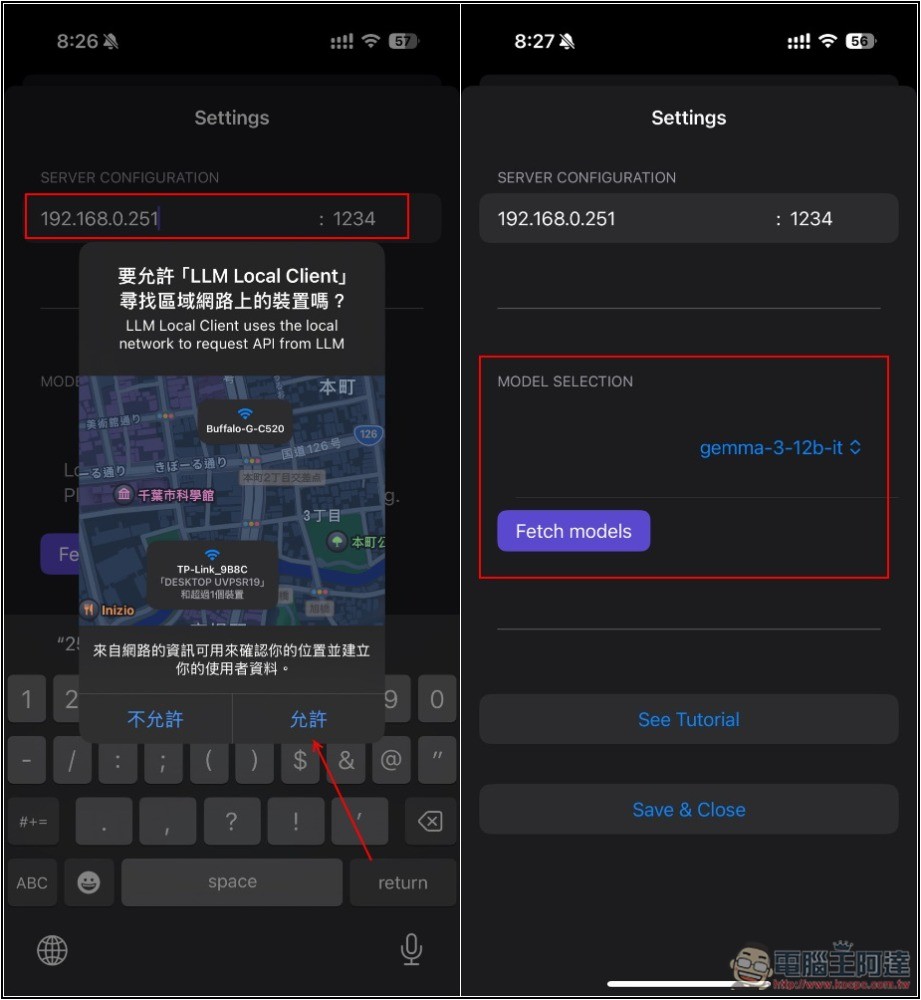

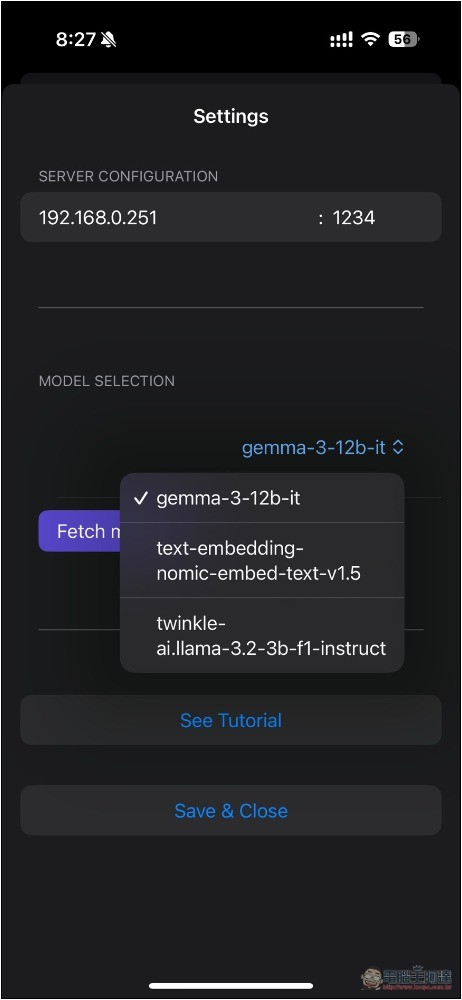

所以我輸入 192.168.0.251,右邊的 Port 預設是 1234,如果你沒改輸入這一串數字就好,記得允許尋找區域網路上的裝置。完成後,如果成功,下方 MODEL SELECTION 就會出現你 LM Studio 已有的模型:

如果你有裝其他模型,跟 LLM 聊天前,就進到設定中切換其他你要用的模型。最後按 Save & Close,就可以開始聊天了:

實測成功,Gemma 3 12B 是絕對無法在 iPhone 上運行的,透過這方法後,再大的 LLM 模型也沒問題,只要電腦跑得動:

iPhone 和電腦不同網路也能遠端用嗎?

可以,但方法不只是這樣,你還需要在路由器上設定 NAT 轉發/反向代理,或是利用 Tailscale、ZeroTier 等 VPN 建立私有網路,我推薦後者,安全性比較高也簡單。

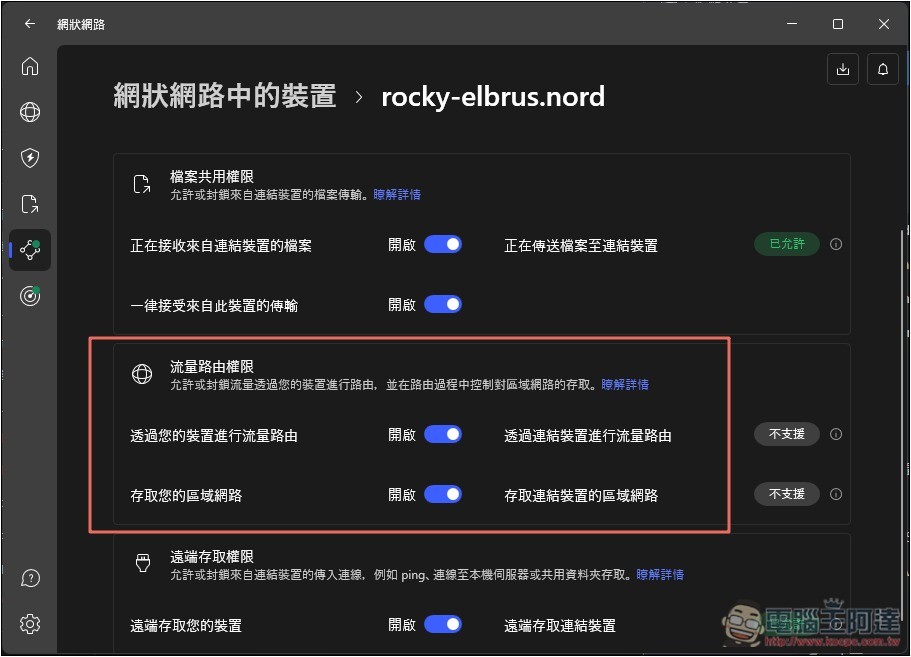

像我平常有在用的 NordVPN,有提供網狀網路功能,其中就有能遠端自己裝置,重新路由網路流量的功能,把電腦端的功能打開:

接著 iPhone 端打開 NordVPN App,進到網狀網路 -> 路由流量功能,在您的裝置中找到電腦,啟用後,iPhone 的數據流量就會先通過電腦,再發送到網路上,意味著變成區域網路了。這時再次打開 LLM Local Client,確保你輸入的 IP 地址是正確的(必須輸入 NordLynx 的 IP,一樣在 ipconfig 會顯示),即便 iPhone 和電腦連接的網路不同,也能遠端使用 LM Studio 模型: