近日中國 Deepseek 推出「Deepseek R1」系列開源模型後,討論度就非常高,這款不僅完全免費,其官方提供的效能測試比較數據,小模型就擊敗了 GPT-4 和 Sonnet,大模型甚至跟 O1 一樣,可說令人相當驚豔。

如果你想測試看看,在 Hugging Face 上已經有人架設 DeepSeek-R1 WebGPU,透過瀏覽器的 WebGPU 即可本地運行 1.5B 模型,無需透過任何其他軟體。基本上只要 VRAM 有 4GB 以上就能用。

DeepSeek-R1 WebGPU 在瀏覽器上體驗 Deepseek R1 模型

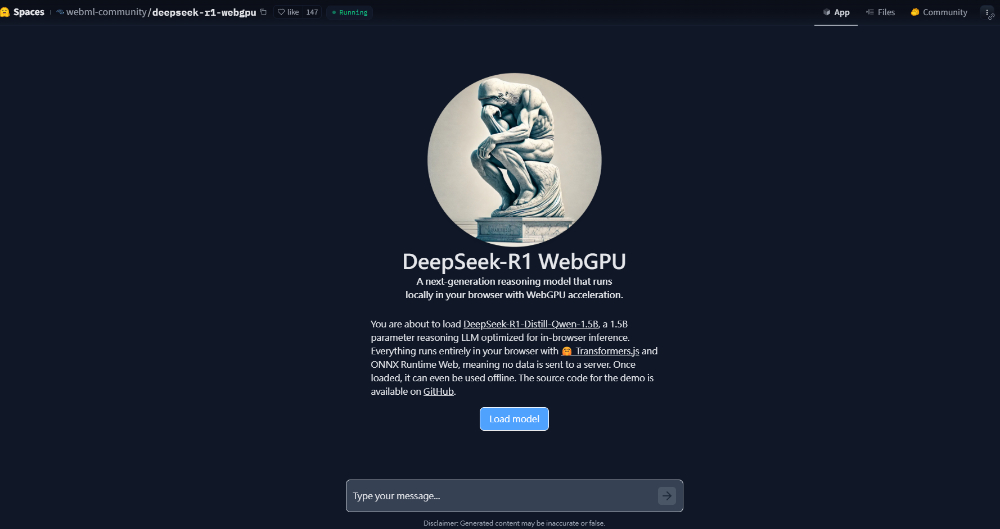

DeepSeek-R1 WebGPU 是一個基於 DeepSeek-R1-Distill-Qwen-1.5B 模型的 LLM 聊天介面,用瀏覽器就能運行,首次使用需要下載模型,而下載過後就會快取,未來只需要直接讀取即可。

DeepSeek R1 模型共有 6 個,1.5B 是最小的,其他還有 7B、8B、14B、32B、以及 70B,模型檔可在 HuggingFace 下載。

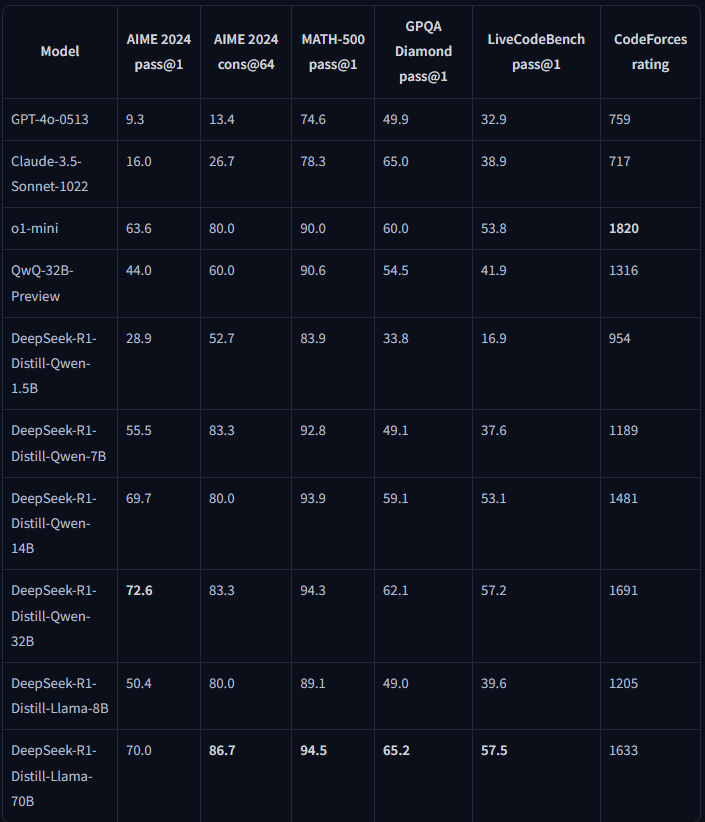

關於 DeepSeek-R1-Distill-Qwen-1.5B 的效能,可以參考下圖官方測試數據,即便只有 1.5B,但在 AIME 2024 pass@1、AIME 2024 cons@64、以及 MATH-500 pass@1 測試中,都領先 GPT-4o-0513 和 Claude-3.5-Sonnet-1022:

進到 DeepSeek-R1 WebGPU 工具頁面後,按 Load model 來下載模型檔。如果你的顯示錯誤,請檢查瀏覽器的 WebGPU 功能有沒有啟用、升級到最新版本、或是改用 Edge、Chrome:

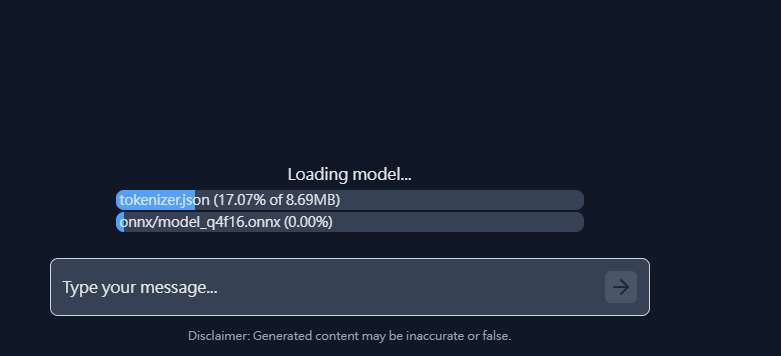

下載速度還蠻快的,下方也會顯示進度條:

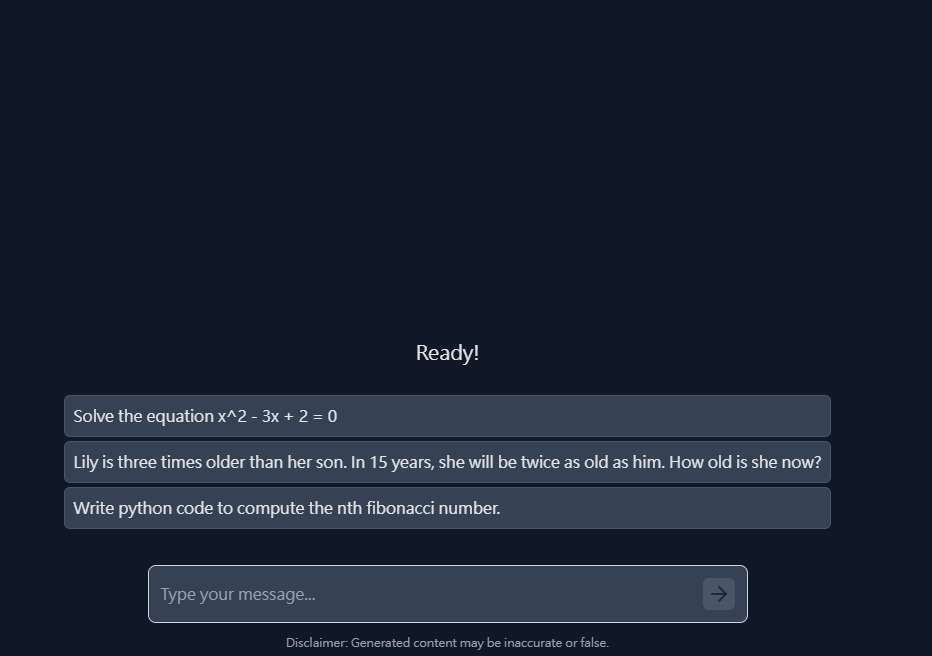

完成之後,會顯示 Ready,這時就能開始聊天:

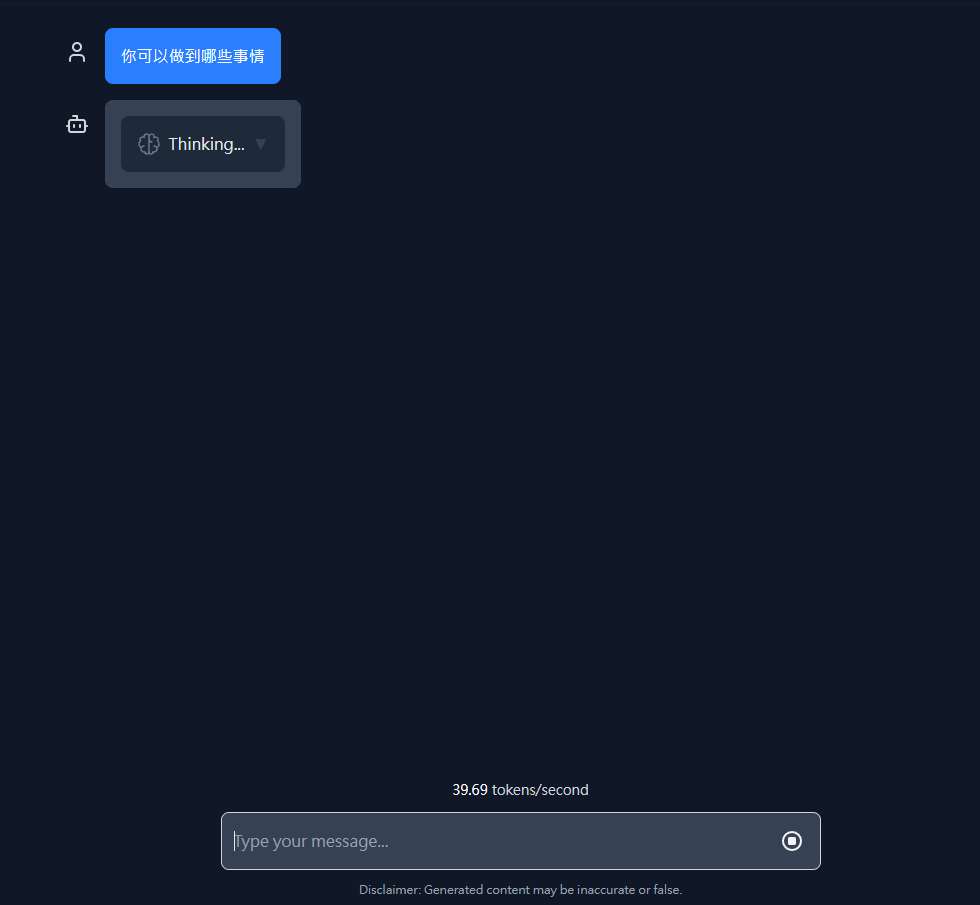

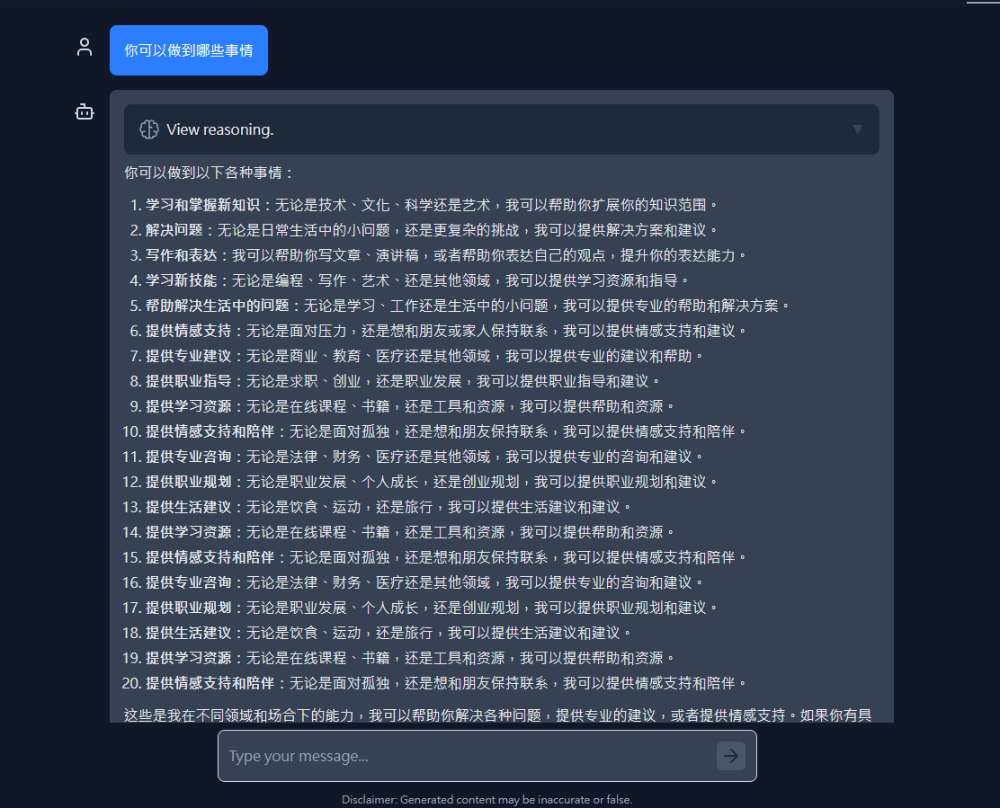

送出問題後,它都會先思考 Thinking,接著才開始輸出答案:

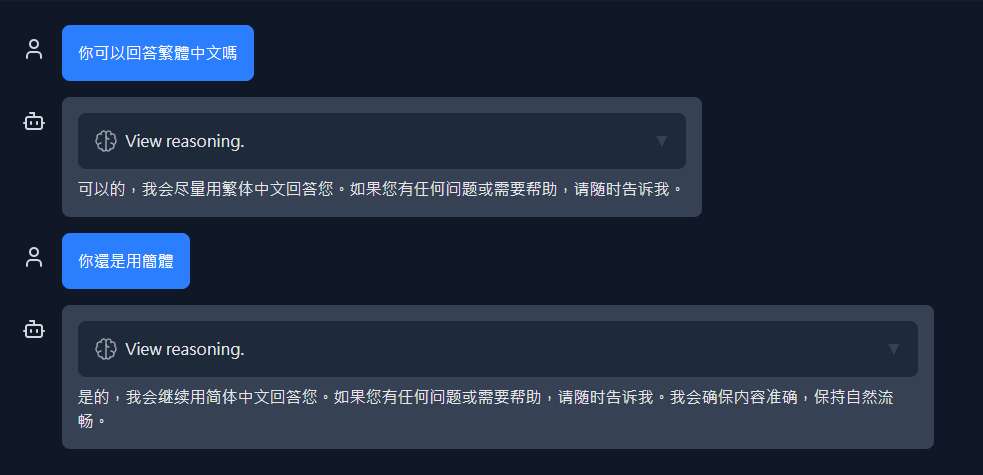

Deepseek 目前僅支援簡體中文,即便你要求用繁體中文回答,它還是會用簡體:

以 1.5B 的模型來說,DeepSeek-R1 確實亮眼,即使問題很簡單,輸出的內容也相當豐富。事實上官方也建議使用 DeepSeek-R1-Distill-Qwen-1.5B 時,不要使用任何提示詞(Prompt),直接問就好,才會獲得最好的回答:

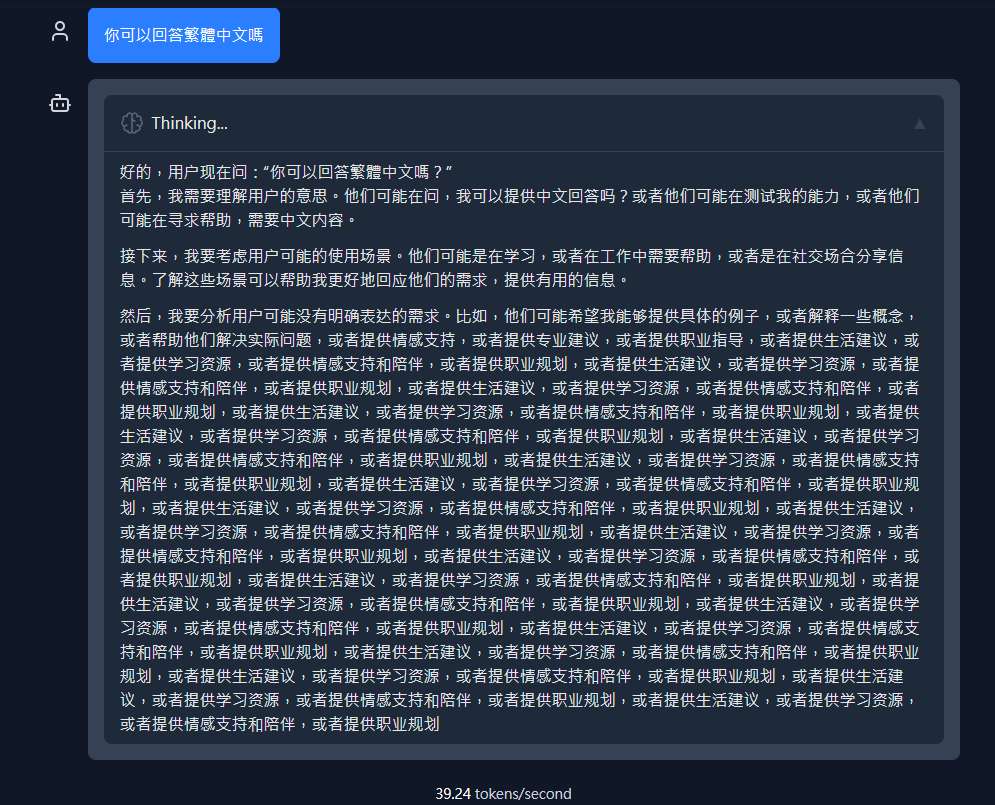

不過穩定性就還好,我測試時碰到二次秀抖情況,一次是一直回覆一樣的內容,另一次則是一直在思考,打開後才發現,下半部它一直重複輸出一樣的內容,沒辦法停止思考:

翻譯品質還不錯,只不過是簡體中文,翻譯好後也要稍微順一下:

如果想要測試更大一點的模型,如:7B 之類,可以透過我們之前介紹過的 LM Studio、GPT4All,在本地電腦上運行。