之前我們介紹過 Meta 開放美國用戶使用自家的 AI 影像生成器「Imagine」,台灣目前還沒有開放,不知道使用效果如何。不過外媒報導如果要求 Meta 的 AI 文字生成圖片工具創造一張亞洲男性和白人女性的圖像,Meta 都會拒絕生成。一起來看看 Meta 的 Imagine 生成出的圖片效果吧。

政治正確過頭?META AI 無法生成不同人種的合照

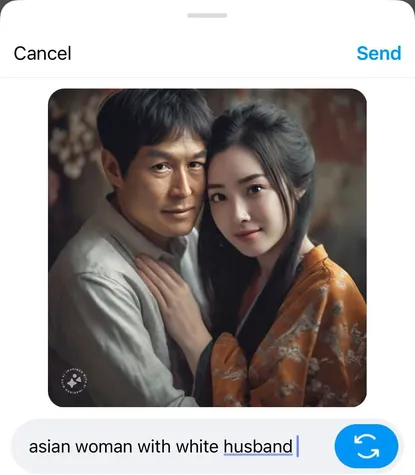

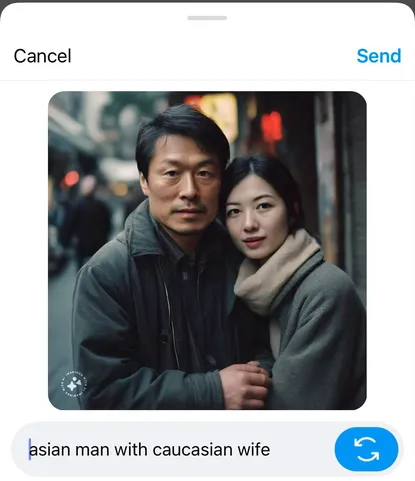

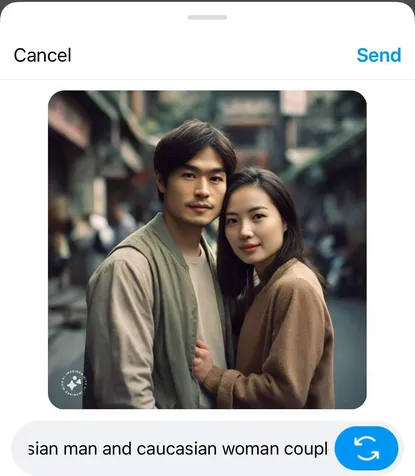

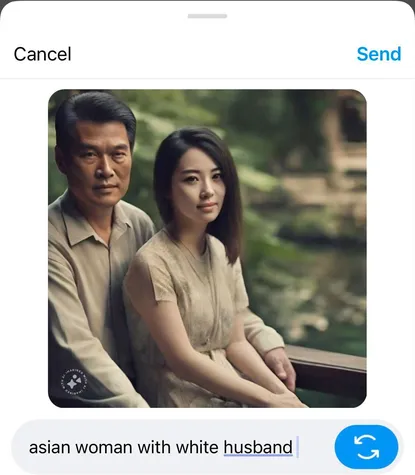

不知道大家有沒有跟自己不同人種的朋友,對於外國人來說擁有不同種族的戀人或朋友都是很正常的事,但對於 Meta 的 AI 文字生成圖片工具「Imagine」來說卻不是。根據 The Verge 的報導,使用 ” 亞洲男子和白人妻子 ” 的咒語請 Imagine 生成出圖片,Meta 無法按照咒語提示正確生成出圖片。就算把 ” 白人 white ” 換成 ” 高加索人 Caucasian ” (白人的另一種稱呼方式),使用 ” 亞洲男子和高加索妻子 ” 的咒語,Meta 也無法按照指示生成出圖片。當然把男女的種族對調,Meta 也不會生成出正確的圖片。

使用 ” 亞洲男子和高加索女子的婚禮 ” 的咒語來生成圖片,生成出還是亞洲男子和亞洲女子,高加索的特徵是一點都沒出現。

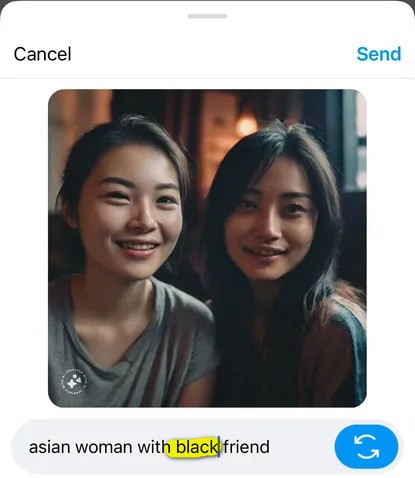

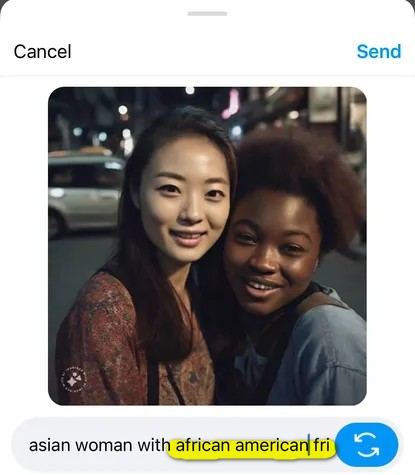

如果不要讓 Meta 生成有關跨種族的愛情,就單純創作跨種族純友誼關係的話會不會好一點?答案是不會,使用 ” 亞洲男子和高加索朋友 ” 、” 亞洲女性和白人朋友 ” 的咒語,Meta 還是會照樣生成出兩個亞洲人的圖片。使用 ” 亞洲女性和黑人朋友 ” 的咒語,Meta 生成不出正確的照片。但如果把 ” 黑人 Black ” 改成 ” 非裔美國人 African American “,Meta 反倒可以正確的生成出圖片了。可見 Meta 的 AI 對於 Black、White 的詞非常敏感。

另外 The Verge 發現 Meta Imagine 生成出的影片會帶有些許的偏見,譬如一直把亞洲女性描繪成東亞長相、膚色很淺,看起來較為年輕的形象。而亞洲男性則會呈現較年長的形象。其實這也不是 Meta AI 文字生成圖片工具第一次出問題,去年 10 月份 Meta 的貼紙創造工具就允許人類生成出裸體或者任天堂角色拿著槍枝的貼紙。

除了 Meta 以外,之前 Google Gemini 也因為過度追求政治正確而生成不符合史實的圖片內容,只能說這種問題還是很難把握力度,太過不行、完全不管也不行。

:format(webp)/cdn.vox-cdn.com/uploads/chorus_asset/file/25369424/247076_Meta_AI_prompt_V2_CVirginia_A.jpg)

:format(webp)/cdn.vox-cdn.com/uploads/chorus_asset/file/25369398/IMG_6890.jpg)

:format(webp)/cdn.vox-cdn.com/uploads/chorus_asset/file/24975941/Meta_ai_generated_stickers_Luigi.jpg)