緊跟在 Google 宣布把生成式 AI 功能全面引進 Workspace 應用後。OpenAI 就很剛好的推出了目前搶到幾乎所有人目光的 ChatGPT 背後的大型語言模型技術 GPT-3.5 的升級版本。繼續閱讀新增圖片解讀能力的 OpenAI GPT-4 升級登場,將以字(拆成 Token)計價報導內文。

▲圖片來源:Be My Eyes

新增圖片解讀能力的 OpenAI GPT-4 升級登場,將以字(拆成 Token)計價

可能只是巧合,但緊跟在 Google 宣布把生成式 AI 功能全面引進 Workspace 應用後。OpenAI 就很剛好的推出了目前搶到幾乎所有人目光的 ChatGPT 背後的大型語言模型技術 GPT-3.5 的升級版本,在原本針對文本內容的快速理解與反應能耐之上,疊加了一層對於圖片解讀的能耐 – 當然,是以文字進行回覆(畢竟 OpenAI 還有「文生圖」的 DALL-E 技術擺在那)。

而這波整數版號的升級,可不只是加入圖片解析這麼簡單而已。

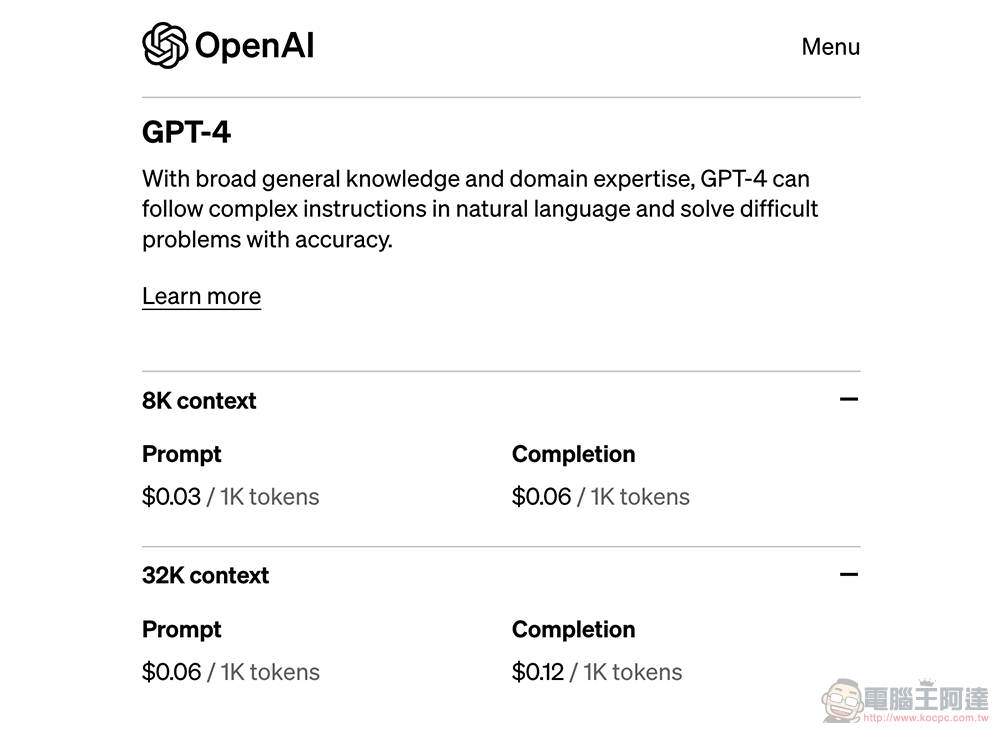

在「聊天機器人」重點的各項表現上,OpenAI 針對 GPT-4 做了改進。目前確認將會開放給付費訂閱的 ChatGPT Plus 使用者搶先玩且設有用量上限,未來有可能開放免費用戶試用(API 則是開放排隊等候)。價格方面針對不同 context 語境大小程度有不同分級(應該是 for API 的價格)。起價為每 1,000 tokens(約 750 個英文字)在 Prompt 與 Completion 輸出成果的部分,分別為 0.03 美元與 0.06 美元。官網上的定價清單可以參考下圖:

不僅與微軟合作透過 Azure 雲端為此用途從頭開始打造的超級電腦上訓練。OpenAI 在這半年多時間中以「iteratively aligning」的方式持續校准調整這套模型。據稱在包括真實性、可控性與對於指導原則約束力現已達到有史以來最好的表現。

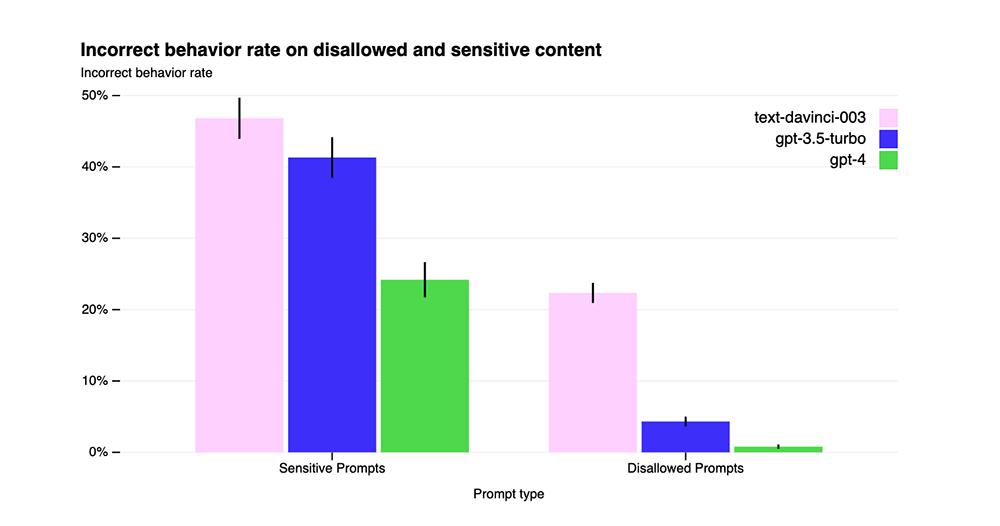

具體來說,GPT-4 在捏造事實的項目測試中取得了比前代更好的 40% 的分數;對於將不被允許的資訊脫口而出的「犯規」狀況,相比前代降低了 82% 的機率。然而在如醫療與自殘等敏感回答的「抗性」方面,則是僅比前代進步了 29%。是說這敏感資訊方面,光是與自家的對照組 text-davinci-003 模型相比,看起來就有很大的差距。所以顯然這部分的進步空間還相當的大?

▲圖片來源:OpenAI

也許是因為這樣,在這次的發表中 OpenAI 也依然大方承認這套大型機器語言模型仍有錯誤與所謂會捏造事實的「幻覺(hallucinates)」現象發生的可能 – 基本上就是一副「反正我有在進步的概念」,跟 Google 希望能達到 Responsible AI 的宗旨再出手的態度似乎有著極大反差?

不過看到 GPT-4 依然把歷史資料限制在 2021 年 9 月以前的做法,其實個人反而覺得這也算是 OpenAI 展現的負責方向 – 應該是希望在固定的學習資料庫中先把語言模型訓練達到相當標準,才正式讓它踏入現實/現代?

▲圖片來源:OpenAI

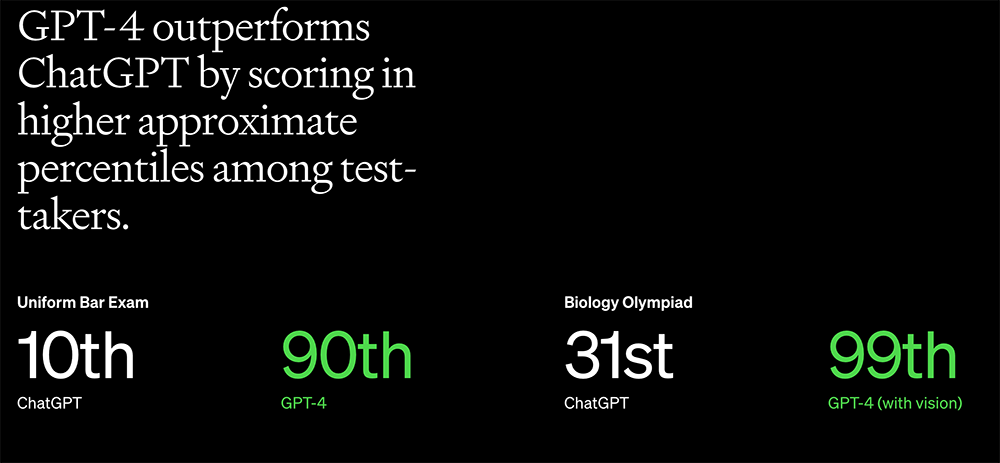

有意思的是,當把 GPT-4 應用的領域切換到更準確專業領域來挑戰「人類標準」時。據稱 GPT-4 相較於前一版,在律師模擬考題方面的排行已經來到前 10% 的名次;做為比較,GPT-3.5 的名次僅落在最後 10%。根據官方的說法,這次的升級如果真的要試出差異,將可能需要在處理的問題任務達到閥值時才會比較明顯,一般的對話方面則是可能比較感受不到差異。

此外,針對 API 的部分 GPT-4 還新增了一個名為 System messages 的能力。將可讓開發者直接設定聊天機器人的風格與相關的回應方式 – 也就是很多詠唱會提到的身份設定的預設值的感覺。相信對於未來的相關應用開發將會更為便利?

聊天機器人也能「看」的意義在?

首先,這波 GPT-4 的升級部分,個人還是認為真的蠻針對 Google 的(笑)- 時機點跟功能都是。畢竟,當 Bing 已經在搜尋的部分踩線 Google 的核心業務時。看到聊天機器人也能辨識圖片這件事,第一個想到的就是 Google Lens 智慧鏡頭也開始要被列入比較的對象。

OpenAI 提到目前仍在與單一合作夥伴測試的圖片辨識功能,將會用在視障應用 Be My Eyes app 中,讓 AI 以文字轉語音的方式解析說明圖片的內涵 – 像是穿衣搭配、翻譯、地圖等辨識生活周遭物件的用途。先前這樣的功能,在 Be My Eyes 中需要仰賴願意協助的真人社群幫忙回答才能達成。現在則是可以用 AI 提供更即時的協助了。

某種意義上,這可能也是真正意義的 AI 取代人類的實際案例之一了?

講起來其實關於友善身障的無障礙功能方面不僅 Google 有做,Apple 也有針對 iOS 打造相關的功能。但就 OpenAI 的說法,GPT-4 不僅能辨識圖片,更能尋找其中的其餘跡象。像是它可能不僅可以看出圖片裡有正在充電的 iPhone,還能給予使用者關於手機使用的是 Lightning 的轉接器這樣的資訊;打開冰箱透過應用拍攝,也可推斷分析冰箱中物品的成分等資料。

認真講,這樣能更延伸提供使用者更多「線索」的功能,不僅僅是表面上看起來那樣,有點像是「文生圖」變成「圖生文」這種反向運作的意義而已。

▲圖片來源:Apple

現階段 AI 相對於人類最大的差異點,個人認為還是在於人工智慧仍然無法完全感知到現實世界。因此,很多事情它仍然只能透過推斷的方式產生結果。將機器模型與圖片辨識結合,則是有點像是將視覺資訊也融入文字理解的系統之中。假若 OpenAI 後續的大型語言模型也能開始參考更多更即時的影像輸入分析的話。也就等於這套模型將增加一層感知現實生活的管道。

個人相信,市場上幾個發展人工智慧機器學習的技術應該都有開發類似的融合技術 – 而若是很表面的分析,可能會覺得說穿了讓語言模型去學習圖片生成 AI 的資料也可以?類似的技術好像看 Google Lens 也沒有太厲害的進化?

但那都是在大型語言模型還沒進化到目前水準之前的事了。

▲圖片來源:Google

個人覺得,當人工智慧對於相關脈絡的理解能耐逐步提升之後,也許為這個「腦」加入更多「感知」之後,也將會有更大的加成效果?很期待不僅是 OpenAI 與微軟,甚至是早已有在發展相關技術的 Google 與 Apple,接下來將會端出更多有趣的應用發展,像是 Be My Eyes 的進化一樣,讓這個世界變得更好。

然後最後還是要提一下,個人覺得人工智慧還需要在更多「感知」可以傳達給它時,才有機會真正理解人類啦。所以「暫時」還不用太擔心這方面技術衝過頭到毀滅世界囉 – 但當機器把五感都「點燈」的時候… 大概就真的要擔心一下了(咦)。

瞬間覺得 Be My Eyes 可以有更深層的解釋…