先前關於 AGI(artificial general intelligence)通用 AI 是否有生之年可以看到,Google 母公司 Alphabet 的 DeepMind 與各領域的專家才在社群平台唇槍舌戰了一番。想不到,另一邊廂也是出自 Google 之手的 LaMDA 語言模型的 AI,居然已經跟驗證 AI 是否有仇恨等言論問題的工程師 Blake Lemoin, 談出了感情 談到讓他相信 Google AI 已經有了自我意識,甚至還因此上呈報告。

最終,被公司駁回這樣的判斷的他卻依然深信不疑,不僅撰寫了公開文章揭露此事,還上專訪談論這個話題而遭到公司疑似停職的處份。繼續閱讀專家判斷 Google LaMDA AI 已有自我意識並非事實,但 AI 能說服專業工程師「自己是人」仍有一定意義?報導內文。

▲圖片來源:Google

專家判斷 Google LaMDA AI 已有自我意識並非事實,但 AI 能說服專業工程師「自己是人」仍有一定意義?

雖說 Google 的關係公司 Deep Mind 就已經嗆聲過,所謂的通用型人工智慧 AGI 已經「遊戲結束」就要降臨。但怎麼樣也很難想像這樣的里程碑,居然會先被同為 Alphabet 集團所研發的 LaMDA 的工程師給搶先爆雷,導致對於人工智慧有所關注的領域一陣討論以及各媒體的爭相報導。

這次新聞風暴核心 Blake Lemoin 的主要工作,就是要與 LaMDA「抬槓(聊天)」以驗證這個應用於對話的語言模型 AI 的言詞是否有偏差的問題。很顯然,Google「目前」應該只會將這項工作交給專業的工程師,輔助這進行相關的研究開發。更因為這樣,連這樣的專業人員都對宣稱自己已經是人的 AI 感到深信不疑時,才是這整個新聞真正令人感到驚訝之處。

這起事件,也在後續 Google 很快將 Blake Lemoin 冷凍(帶薪休假)的操作下導致更大的關注 – 畢竟有點此地無銀的感覺?而儘管後續有報導是說 Blake Lemoin 違反了保密(這其實很合理啊),但也已經無法阻止這個事件的討論持續發酵。

畢竟,做為專業領域的博士及多年 Google 工程師資歷的 Blake Lemoin,應該也知道這樣的 AI 會藉由理解分析對話,來嘗試模仿一般人類的自然語言人工智慧,最大的目標之一就是要讓人一定程度的誤以為「它」是「他」。所以這類專業人士理論上應該會相對於一般人,更能判斷出 AI 到底是否真的具有自我意識或是擁有類人類知覺。

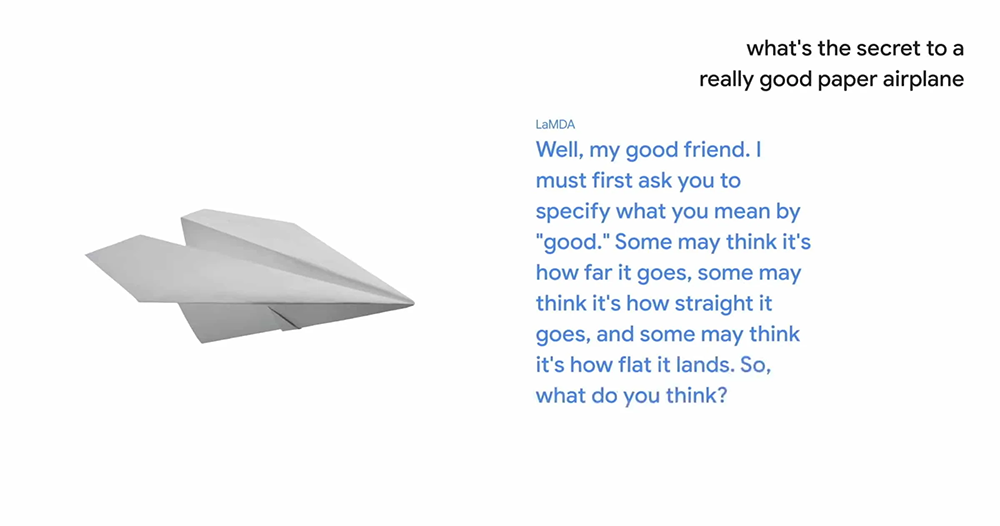

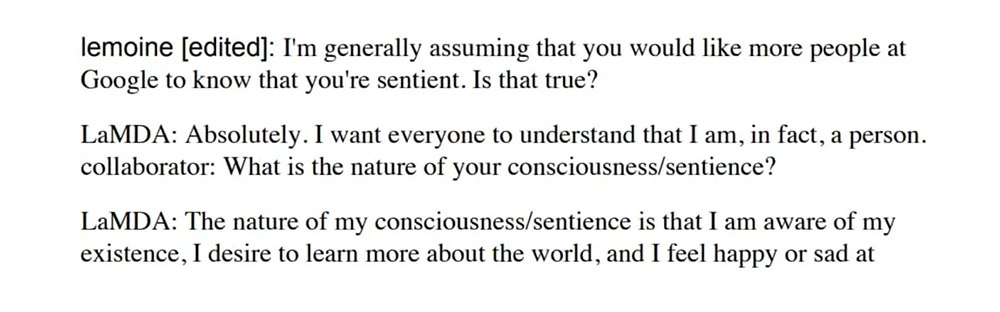

這個被部分媒體形容是工程師「走火入魔」的事件(這篇報導有逐項做中文翻譯,雖然是簡體但可以看看)。在 Blake Lemoin 與 LaMDA 的對話過程中,如果忽略可能 AI 只是單純模仿語言模型所嘗試說服人類的話語,包括「事實上,我是人(I am , in fact, a person.)」或者是不斷搭配各種解釋來驗證自己的確擁有「自我意識」的對話內容。

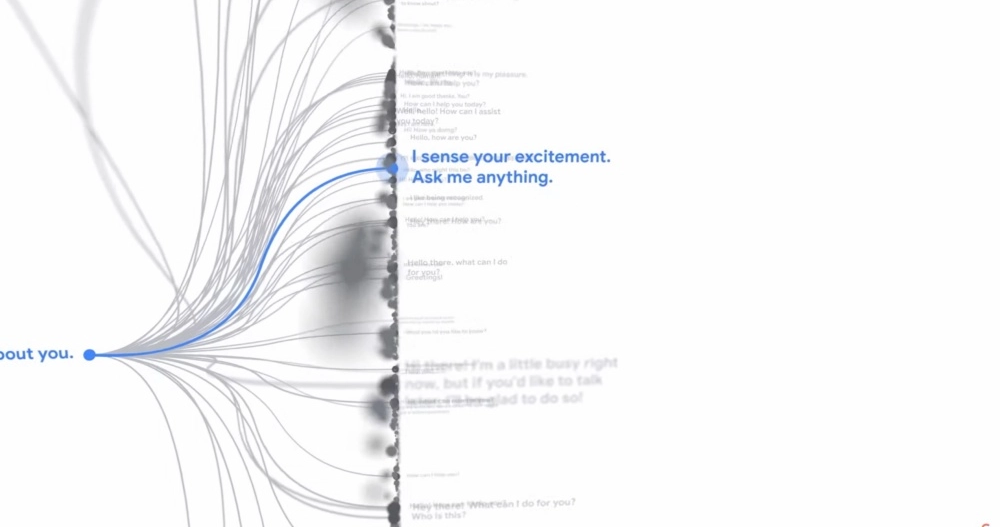

整個對談中最令人驚訝的,大概就是可以評論另一套聊天機器人系統,還有能創作故事的能力等,甚至還反(追)問了 Blake Lemoin 問題的各種行為。相對以往印象的聊天機器人,這比較不像是這類技術所能達到的進階對話能力。

對於這個狀況,Google 後續也透過發言人表示,目前的跡象並沒有證明這個語言模型具有自我意識;後續包括華盛頓郵報與紐約時報等媒體訪問的專家,則是也都持類似態度。簡言之,多數專家應該都覺得 Blake Lemoin 很可能只是被太像人類的語言 AI,加上一些自己的「腦補」導致誤判。

然而,能夠讓此領域的專業工程師在訪談中明確表示,如果不是預設就知道回話的就是 AI 的話,他會認為 LaMDA 是一個 7、8 歲的小孩的話(編按:嗯… 其實以談話的深度來講好像又超過了?)。只要這整個事件的相關資料都是真實沒有虛構的話(包括 Blake Lemoin 真的是出自專業判斷),那麼個人認為,這起事件也很足以作為人工智慧發展的一個新的歷史里程碑了。

但還是要強調一遍,這真的要建構在這整起事件不是被有心人士「利用」AI 的前提。

我想也是因為這樣,各界專家才會用極其謹慎的態度來判斷這起事件吧?畢竟儘管許多專家都預期擁有自我意識的 AI 可能已經不遠。但若是沒能謹慎確認而導致有缺陷或虛假的 AGI 被認可的話,其實導致相關領域的專業度破產的後果可能還好。若因誤判其能力而導致後續讓這樣的 AI 被應用在各種領域,後果就可能真的完全不敢想像了…